概率论与数理统计

siwing

2020 年 8 月 27 日

2

目录

第一部分 概率论初步 1

1 概率的本质 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 3

1.1 贝叶斯派(主观概率派) . . . . . . . . . . . . . . . . . . . . . . . . . . . 3

1.2 频率学派 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 3

1.3 总结 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 4

1.4 如何理解概率 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 4

2 测度 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 5

2.1 幂集 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 5

2.2 σ 代数 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 5

2.3 测度 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 5

2.4 概率测度 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 6

2.4.1 条件概率 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 6

2.4.2 Borel 域 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 7

2.4.3 勒贝格不可测集 . . . . . . . . . . . . . . . . . . . . . . . . . . . 7

2.4.4 开集与闭集的概率 . . . . . . . . . . . . . . . . . . . . . . . . . . 7

3 概率的公式 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 7

3.1 加法公式 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 7

3.2 乘法公式 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 8

3.2.1 条件概率 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 8

3.2.2 乘法公式 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 8

3.3 全概率公式 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 9

3.4 贝叶斯公式 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 9

3.5 总结 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 10

4 独立与不相关 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 11

4.1 事件的独立性 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 11

4.2 试验的独立性 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 12

4.3 随机变量的独立性 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 12

4.4 线性相关性 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 12

4.5 不相关与独立的关系 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 12

3

目录

第二部分 基础概率论 15

5 随机变量 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 17

5.1 离散型随机变量 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 17

5.2 连续型随机变量 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 17

6

概率分布

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 17

6.1 分布函数(概率分布函数) . . . . . . . . . . . . . . . . . . . . . . . . . . 17

6.2 分布列 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 18

6.3 概率密度函数 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 18

6.4 总结 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 19

7 期望 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 19

7.1 期望的性质 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 19

8 方差 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 19

8.1 方差的性质 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 20

8.2 切比雪夫不等式 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 20

9 排列组合 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 22

10 一维离散分布 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 23

10.1 二项分布 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 23

10.1.1

期望与方差的推导

. . . . . . . . . . . . . . . . . . . . . . . . . . 23

10.1.2 二项分布期望与方差的简单推导 . . . . . . . . . . . . . . . . . . 24

10.1.3 名字由来 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 25

10.2 伯努利分布(0 − 1 分布) . . . . . . . . . . . . . . . . . . . . . . . . . . . 25

10.3 泊松分布 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 25

10.3.1 推导泊松分布 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 25

10.3.2 泊松分布期望和方差的推导 . . . . . . . . . . . . . . . . . . . . . 26

10.3.3 poisson 分布的由来 . . . . . . . . . . . . . . . . . . . . . . . . . 27

10.4 超几何分布 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 27

10.4.1 超几何分布的期望和方差 . . . . . . . . . . . . . . . . . . . . . . 28

10.5 负二项分布(帕斯卡分布) . . . . . . . . . . . . . . . . . . . . . . . . . . 28

10.5.1 名字由来 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 29

10.6 几何分布 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 29

10.6.1 几何分布的期望和方差 . . . . . . . . . . . . . . . . . . . . . . . 29

10.6.2 几何分布的无记忆性 . . . . . . . . . . . . . . . . . . . . . . . . . 30

10.6.3 名字由来 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 30

11 各一维离散分布的联系 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 30

11.1 总结 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 31

12 一维连续分布 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 31

12.1 正态分布(Gauss 分布) . . . . . . . . . . . . . . . . . . . . . . . . . . . 31

12.1.1 标准正态分布 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 31

4

目录

12.1.2 正态分布的期望和方差 . . . . . . . . . . . . . . . . . . . . . . . 31

12.2 均匀分布 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 32

12.2.1 名字的由来 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 32

12.3 指数分布与其无记忆性 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 32

12.3.1 负指数一词的由来 . . . . . . . . . . . . . . . . . . . . . . . . . . 32

12.4 Weibull 分布 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 32

12.5 伽马分布 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 33

12.5.1 伽马分布的性质 . . . . . . . . . . . . . . . . . . . . . . . . . . . 33

12.5.2 伽马分布的两个特例 . . . . . . . . . . . . . . . . . . . . . . . . . 33

12.6 贝塔分布 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 33

13 随机变量函数的分布 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 34

13.1 分布函数法 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 34

13.1.1 步骤 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 34

13.2 定理法 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 34

14 分布的其它特征数 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 36

14.1 k 阶矩 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 36

14.1.1 中心矩与原点矩的关系 . . . . . . . . . . . . . . . . . . . . . . . 37

14.2 变异系数(离散系数) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 37

14.3 分位数 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 37

14.4 中位数 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 38

14.5 偏度 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 38

14.6 峰度 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 38

15 参考文献 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 38

第三部分 概率论进阶 39

16 随机变量序列的四种收敛 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 41

17 大数定律 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 42

17.1 伯努利大数定律 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 42

17.2 大数定律一般形式 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 43

17.3 切比雪夫大数定律 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 43

17.4 马尔可夫大数定律 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 44

17.5 辛钦大数定律 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 44

17.6 总结 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 44

18 中心极限定理 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 45

18.1 独立同分布下的中心极限定理 . . . . . . . . . . . . . . . . . . . . . . . . . 45

18.2 二项分布的正态近似 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 45

18.3 独立不同分布下的中心极限定理 . . . . . . . . . . . . . . . . . . . . . . . . 45

5

目录

第四部分 数理统计 47

19 抽样分布 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 49

19.1 统计学分布 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 49

19.2 抽样分布的作用 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 50

19.3

三大抽样分布

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 51

19.3.1 χ

2

分布 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 51

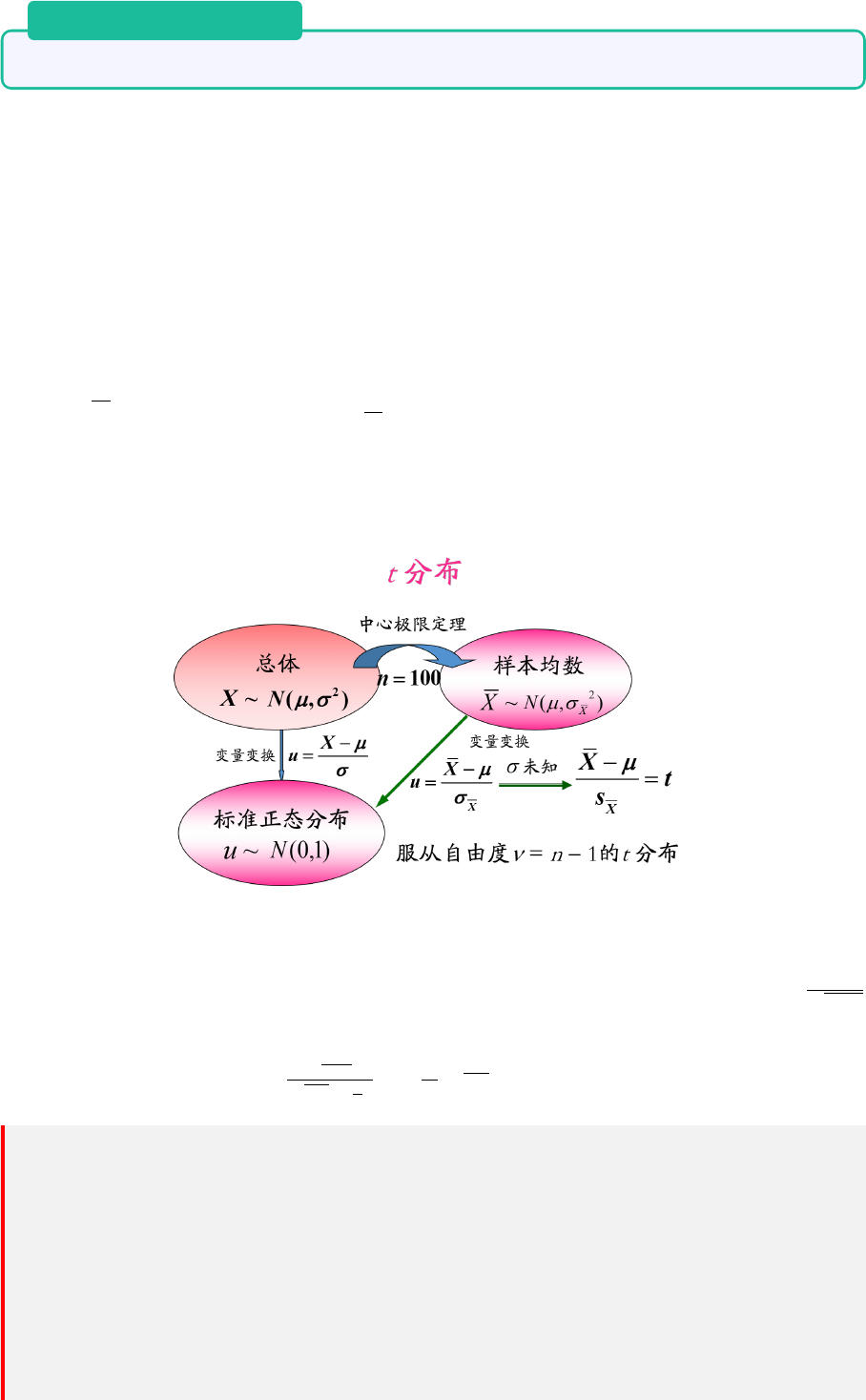

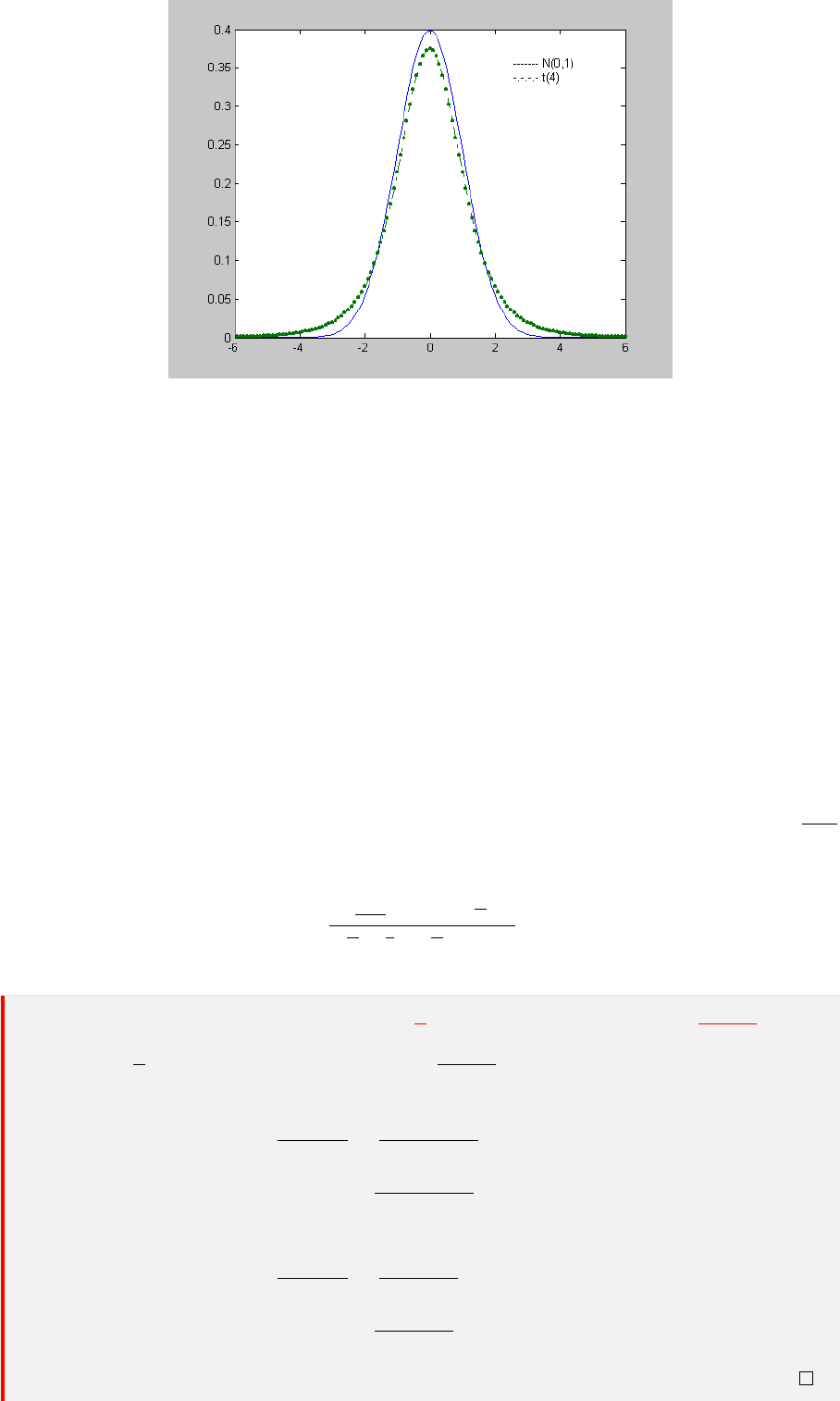

19.3.2 t 分布 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 52

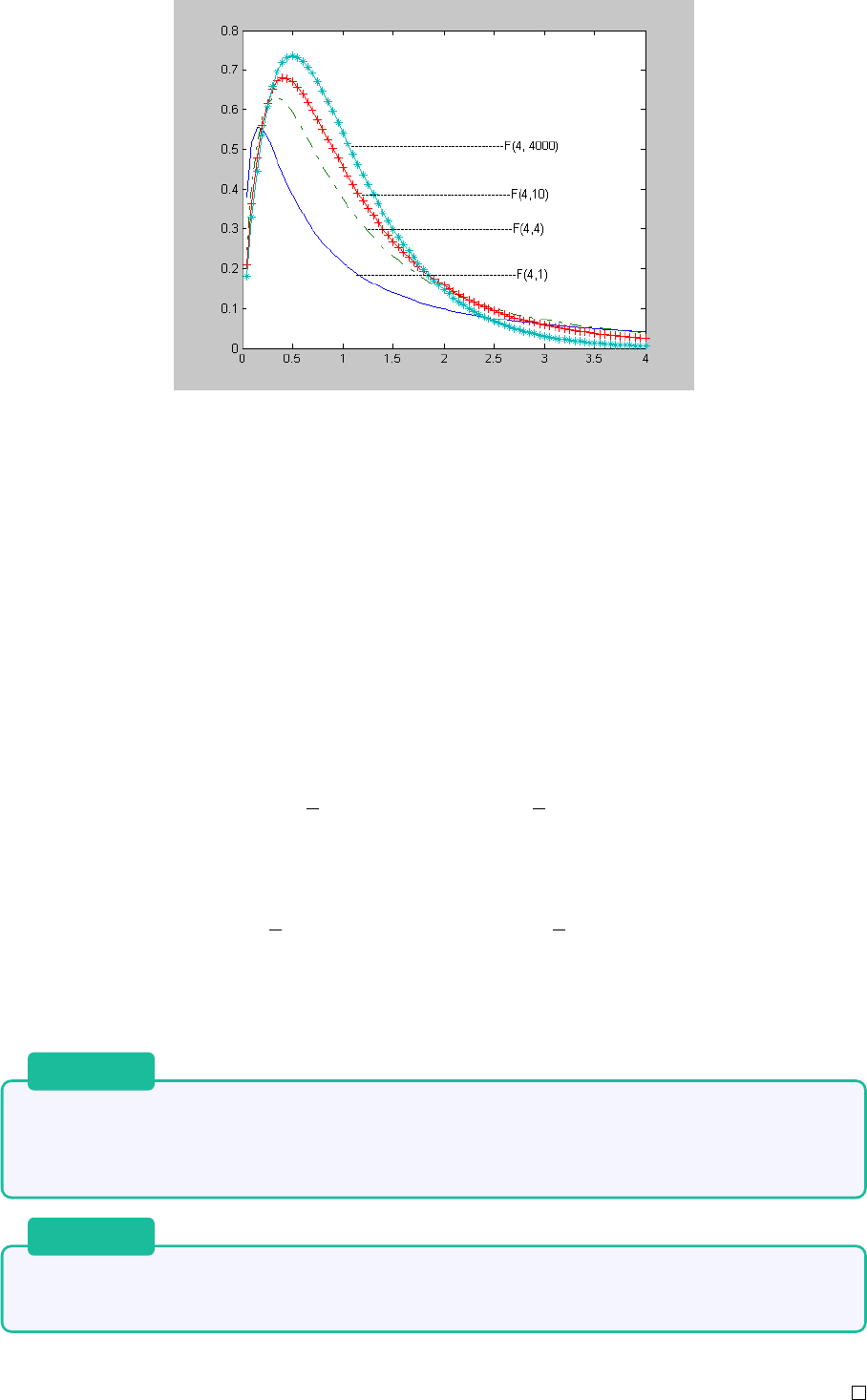

19.3.3 F 分布 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 53

19.4 样本均值 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 54

19.5 样本方差与样本标准差 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 55

19.6 一些重要的结论 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 56

20 参数估计 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 57

20.1 矩估计 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 57

20.1.1 缺陷 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 58

20.2 极 (最) 大似然估计 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 58

20.3 点估计 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 59

20.4 区间估计 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 59

20.4.1

构造置信区间——枢轴量法

. . . . . . . . . . . . . . . . . . . . . 60

20.4.2 构造置信区间的原则 . . . . . . . . . . . . . . . . . . . . . . . . . 60

20.4.3 区间估计与点估计的联系 . . . . . . . . . . . . . . . . . . . . . . 61

20.5 点估计量的评判标准 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 61

20.5.1 相合性 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 61

20.5.2 无偏性 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 62

20.5.3 有效性 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 62

20.5.4 直观理解各标准的区别 . . . . . . . . . . . . . . . . . . . . . . . 62

20.6 判断 UMVUE . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 63

21 假设检验 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 64

21.1 小概率原理与统计归谬法 . . . . . . . . . . . . . . . . . . . . . . . . . . . 64

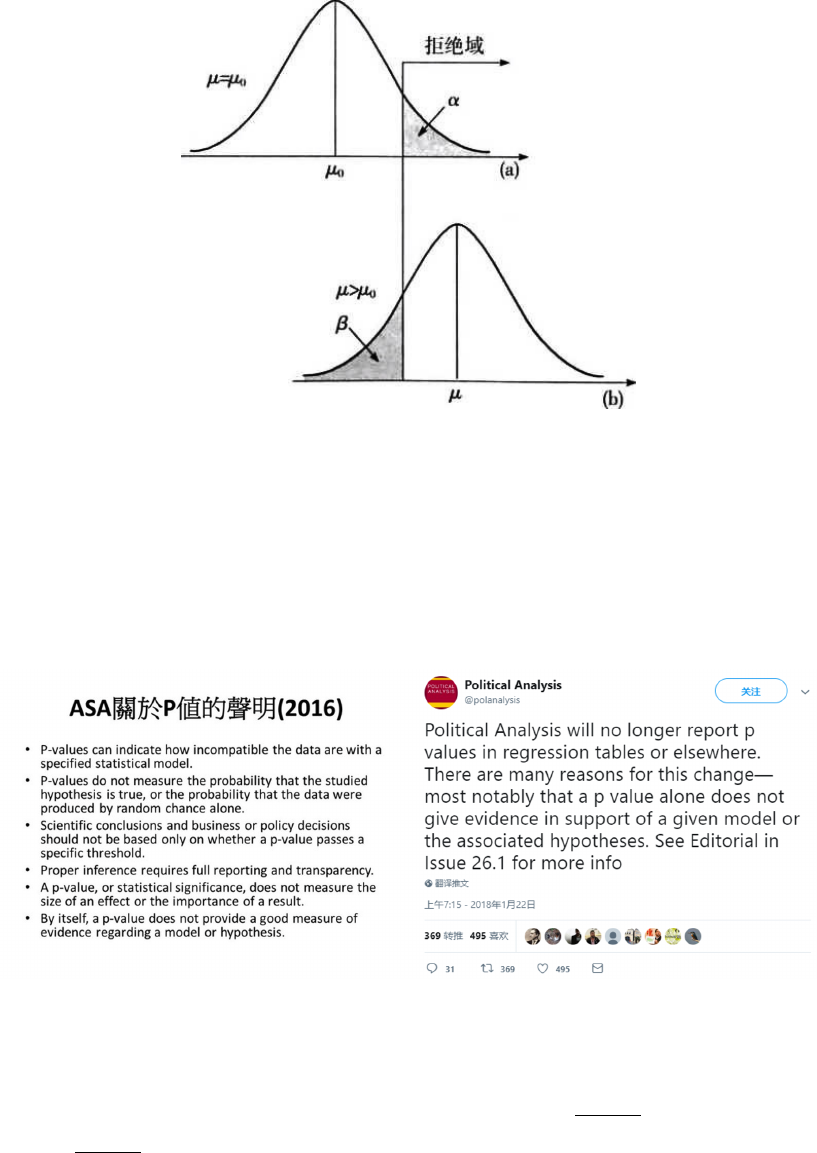

21.2 相关概念 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 65

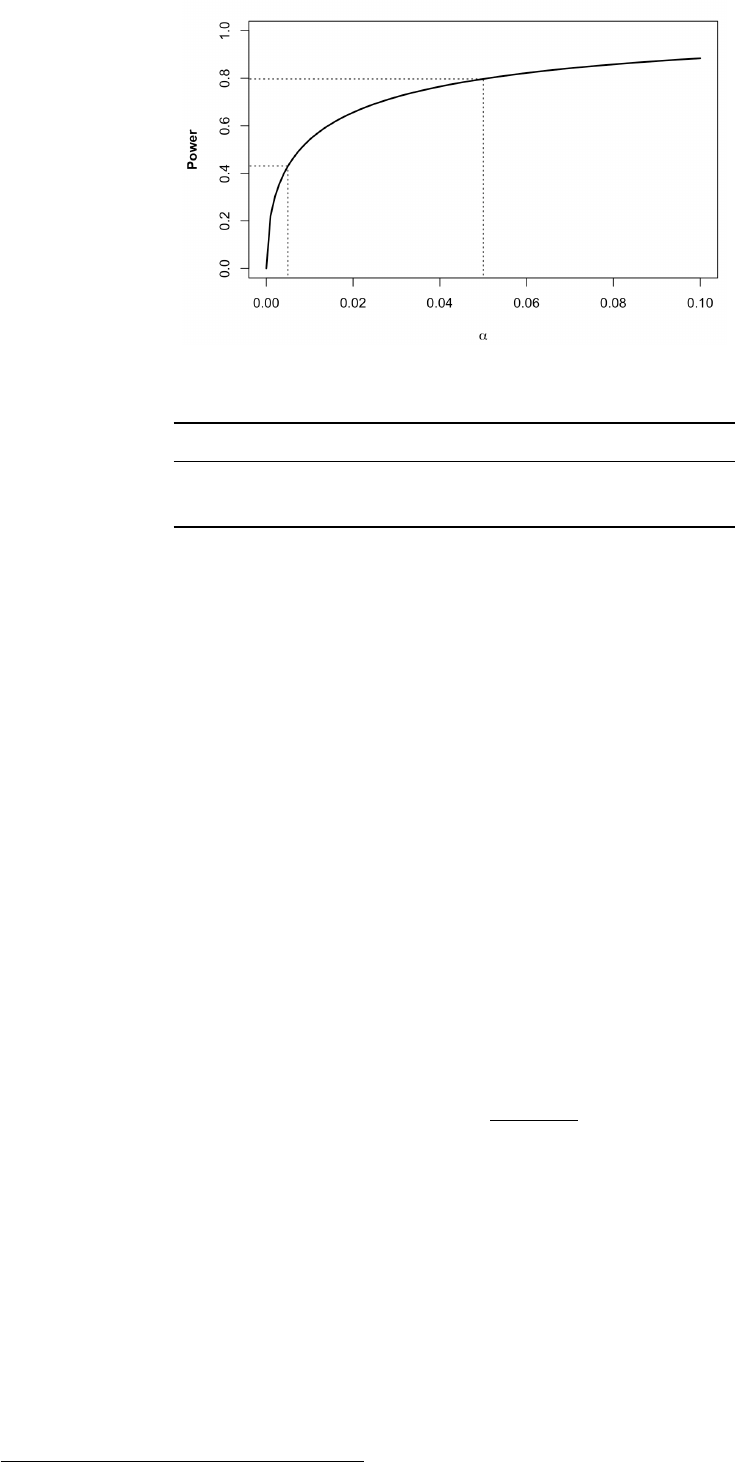

21.3 α 错误 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 66

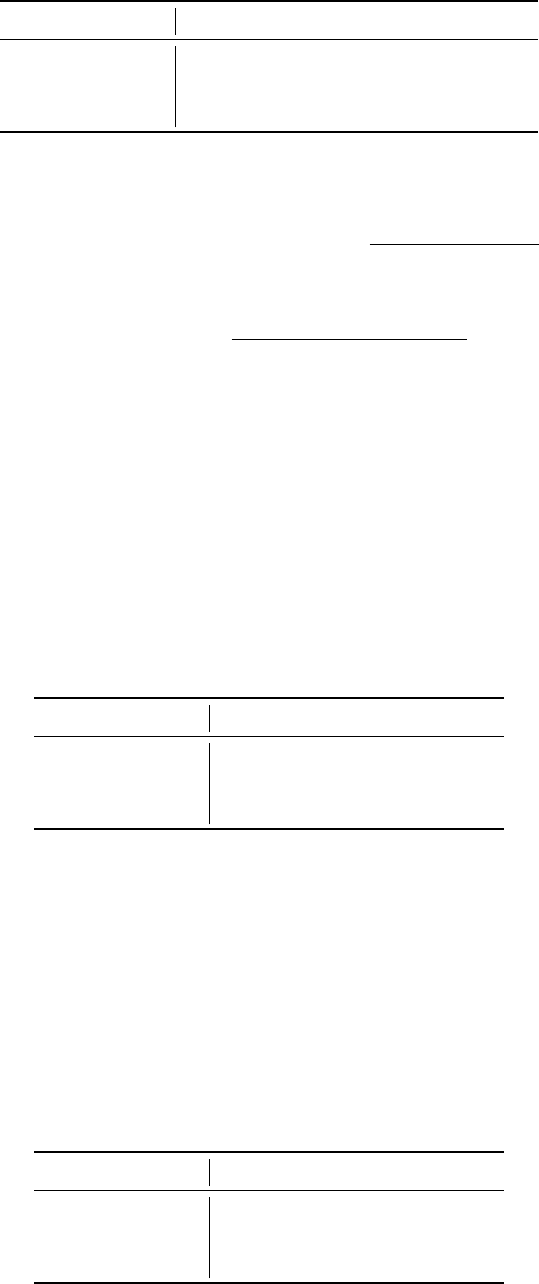

21.4 P 值 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 68

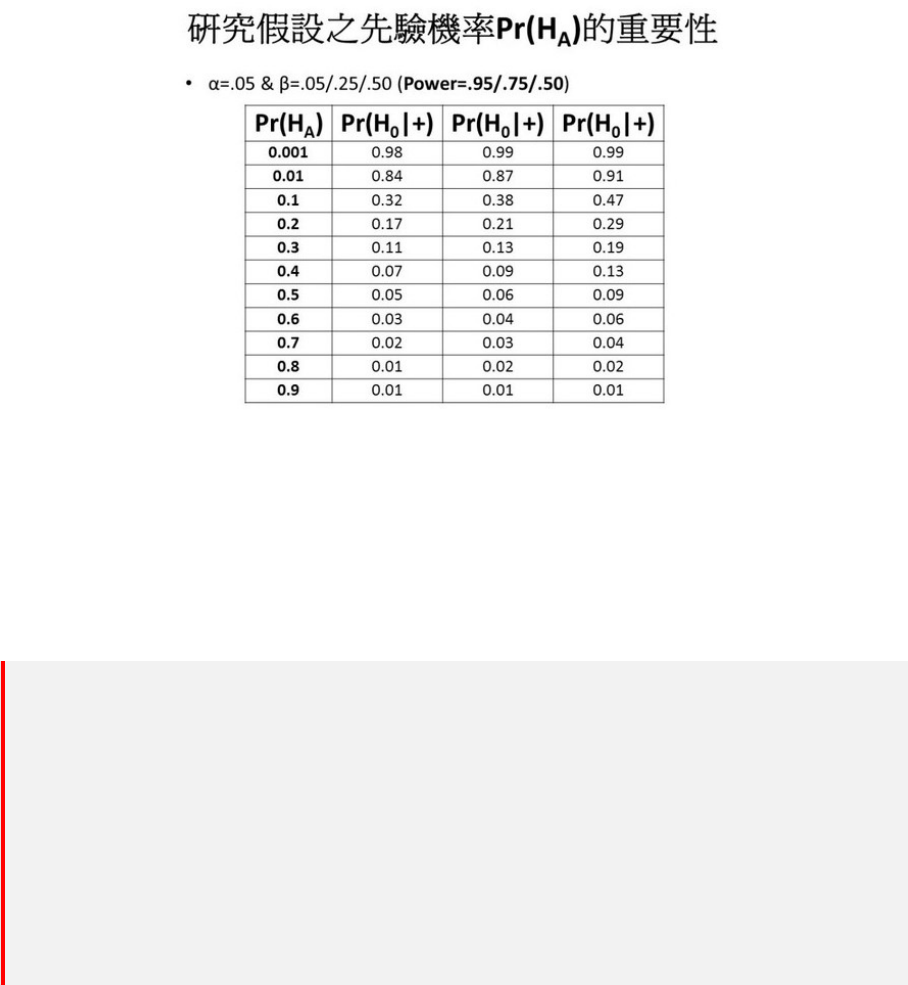

21.4.1 P 值危机 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 68

22 抽样分布、参数估计、假设检验的联系 . . . . . . . . . . . . . . . . . . . . . . . . 71

23 概念基础 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 72

23.1 统计量的极限分布、大样本与小样本 . . . . . . . . . . . . . . . . . . . . . 72

23.2 充分统计量 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 72

23.3 参数估计 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 72

23.3.1 点估计 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 73

6

23.3.2 极大似然估计 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 73

23.3.3 矩估计与极大似然估计 . . . . . . . . . . . . . . . . . . . . . . . 73

23.3.4 区间估计 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 73

参考文献 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 75

第一部分

概率论初步

1

1 概率的本质

1 概率的本质

如何定义概率是一个很难的问题,甚至我们难以确定这个世界是否存在概率。换而言之,这个世

界真的存在随机吗?而概率又是统计学的核心,因此有必要探讨一下概率的本质。

出于对世界是否随机问题的不同认知,统计学可以分为两个学派:频率学派、贝叶斯学派。

1.1 贝叶斯派(主观概率派)

贝叶斯学派用信念的强度(degrees of partial belief)来定义概率。根据这个定义,概率并不是

关于物理系统的,而是关于物理系统和我们之间的关系。也就是说,概率并不是物理世界的本质

属性之一,概率只是人类描述世界的一个工具。

抛一枚硬币有正反两个结果,平时我们认为出现正反两面的概率都是 1/2。但在牛顿经典力学的

框架下,掷硬币的结果是完全决定性的(fully deterministic):硬币和其所在环境的组成的物理

系统在某个时刻的状态是由其前一个时刻的状态决定的。如果我们知道这个系统的初始状态,知

道组成这个系统每一个粒子最开始的速度和位置,原则上通过经典的动态方程,可以计算出这个

系统在之后每一个时刻的状态。

然而,由于我们不知道这个物理系统的全部细节,无法做出精准的预测,只能预测一个大概的结

果,而这个结果就是通过概率的形式来表达的。

再举一个例子:玩扑克牌中的时候,如果对手只剩下两张牌的时候,你要猜测他手里的牌型。你

通过超强的记忆力和精确的演算,推断出他手里的牌是两张单张的可能性稍微大一些(可能性

是 2/3),虽然也有可能是一对(可能性是 1/3),所以你决定接下来打对子。这样的不确定性就

来自于信息的匮乏。因为在对方的眼里,他的牌型是确定性的。要么是单张,要么是一对,非此

即彼,不存在

“2/3

是单张,

1/3

是一对

”

的情况。所以同一个事物的不确定性在不同人的眼里

是不一样的,在缺乏足够信息的情况下,我们虽然能够基于现有的信息进行估计,但是无法推断

出准确的结论;拥有的相关信息越充分,不确定性越低。

根据贝叶斯派,概率代表了我们对于某个事件的信念。如果我们相信这个事件一定会发生,概率

则为 1;如果我们相信这个事件一定不会发生,概率则为 0;如果我们相信这个事件有可能发生,

而测量关于它会发生这个信念的强度就是概率,介于 0 和 1 之间。

但是贝叶斯学派存在难以解释的问题:

1. 如果概率只是对于人们信念强度的测量,那么每个人对于同一个事件会有不同的信念,也

就会给出不同的概率。但是,一般认为像掷硬币这样的事件是存在一个客观的、在不同的

人之间统一的概率。

2. 为什么代表了信念强度的概率满足概率的公理化定义。

1.2 频率学派

频率学派认为概率是物理世界的一个本质属性,不随着人的意志的转移而发生改变。在频率学

派的角度上,概率的测量依靠独立可重复的试验,如果独立可重复试验不断进行下去的话,频率

就会逼近概率,也就是说频率的极限等于概率。

Note: 概率是物理世界的一个本质,也就是说物理世界存在随机,随机的含义就是事物

不被任何东西决定,所以频率派认为概率就是概率,概率就是频率的极限,没有什么更深

层次的原因解释或是决定概率。

频率学派的观点符合量子物理中的一些发现。有些事件是确定性的,比如说如果伽利略松手,铁

球会决定性地砸向比萨斜塔的地面;有些事件则是随机的,比如原子衰变是随机的,这个粒子接

下来可能会衰变,也可能不会,比如说相同的一束所有光子完全一样的光束,在面对与之倾斜的

3

1 概率的本质

偏振片时,一部分光子通过了偏振片,而另一部分光子却没有通过。

但是频率学派确定概率的方式也存在缺陷:

1. 确定一个事件发生的概率需要通过大量重复试验,也就是要求这个事件重复发生,但实际

上,现实中有一些事情不是经常发生的,甚至是无法重复的。例如说,大地震发生的概率,

大地震显然不会经常发生,但我们仍然可以给它定一个概率,又比如说手术的成功的概率,

手术显然不可能重复进行(不会对同一个人进行多次重复手术),显然用频率来确定概率

在这里就会遇到困难。

1.3 总结

如果物理世界可以通过清晰的实体——现象进行二元区分。也就是说,任何事物都有一个 “实

体”,而人类要通过观测这个实体的的现象,来推断实体的性质。贝叶斯派的观点是实体不一定

存在 p 这个参数,参数 p 只是被我们用来研究现象,这就是观察者的角度。而频率派的观点是

参数 p 是存在于实体的,但是我们无法得知,只能通过观测现象去估计参数 p。

实际上,世界是否存在随机,目前可能并没有完全确定的答案,只能说世界存在随机的证据更多

一些。科学史上有不少著名的争论就是源于随机是否是世界本质的讨论。例如爱因斯坦和薛定

谔就非常不喜欢世界存在真正的随机这种观点。所以爱因斯坦说:God does not play dice with

the universe. 而薛定谔提出了“薛定谔的猫”的思想实验。

爱因斯坦这句话的含义是:宇宙中没有真正的随机,这表明了爱因斯坦对量子力学的态度,在世

界观上,爱因斯坦是机械决定论者。

也正是由于以上两种概率的定义方法都有局限性,所以才有人提出了概率的公理化定义。当然,

虽然一般称之为概率的公理化定义,但是这并不是真正意义上的定义。也就是说,被公理化定义

的概率是符合 Kolmogorov 公理要求的事物的集合。公理化系统的目的就是为了避免对概念进

行具体的定义而产生局限性。

1.4 如何理解概率

既然 Kolmogorov 公理不是真正的定义,而频率派和贝叶斯派的观点又各有缺陷性,同时世界是

否存在随机还有争议,那么应该如何理解概率?

实际上,概率完全可以理解为信息量的测度,甚至是对主观倾向的测量。如果我们掌握一个事物

的信息量越多,我们估计出来的概率就越接近真实情况,如果事物确实是随机的,那么我们也确

实估计出来了一个概率。如果事物是确定性的,我们估计出来的概率也可以用于决策(在目前已

有信息量的前提下,我们做出一个正确决策的可能性有多大),当信息量完全的时候,概率就会

为 1 或 0。

很显然,这样的理解完全避开了频率学派和贝叶斯学派的矛盾,虽然看起来是一个无奈之举,但

也是一个巧妙的的方法。

另外,概率的测量存在缺陷:它的对错和准确性非常难以衡量。由于概率并不是对事件本身的直

接测量,因此事件的结果是不能作为直接衡量概率测量准确性的依据的。比如说甲估计 A 事件

发生的概率为 30%,而乙估计 A 事件发生的概率为 60%,最后 A 事件发生了,难道可以说乙的

估计更好吗?因为甲也认为有 30% 的可能性发生 A 事件,这也是可能发生的事件。

这一点和其他理论有很大的区别。比如利用牛顿力学计算一个炮弹的落点,只要让这个炮弹真

的打出去,看看实际落点与理论落点是否吻合即可,两者距离越近,说明计算的准确性越高。

判断概率估计的优劣,必须回到做出概率估计的那个时刻,判断是否是当下最佳的估计。

4

2 测度

2 测度

2.1 幂集

定义2.1 幂集(power set):给定集合 S,S 的所有子集的集合称为 S 的幂集,记为 P (S)(即

P (S) 的元素都是 S 的子集)。用数学语言表示为:P (S) = {U |U ⊆ S}。

2.2 σ 代数

σ 代数(σ 域):给定集合 S,S 的幂集 P (S) 的一个子集称为集合 S 上的 σ 代数。该子集具有

对“差集运算”和“可数个并集运算”的封闭性(因此对于“可数个交集运算”也是封闭的)。σ

代数在测度论中用来定义可测集合,另外在定义条件期望和鞅的时候也需要用到。

σ 代数的数学定义如下:

定义2.2 σ 代数:设 S 为非空集合,F 中的元素是 S 的子集合,满足以下条件的集合族 F 称为

S 上的一个 σ 代数:

1. S 在 F 中

2. 如果一个集合 A 在 F 中,那么它的差集 A

C

也在 F 中

3. 如果有可数个集合 A

1

, A

2

, A

3

, ···, A

n

都在 F 中,它们的并集也在 F 中

Note: 实际上,以上三个条件即是说 F 对 S 的运算具有封闭性。因为,集合交的运算

可以通过并与对立来实现,集合差的运算可以通过对立与交来实现,所以并与对立是集合

最基本的运算。以上第 2 和第 3 个条件正是说了 F 对 S 的对立和并运算封闭。

在测度论中,(S, F) 称为一个可测空间,F 中的某元素,也就是 S 的某子集,称为可测集合。在

概率论中,可测空间写作 (Ω, F),而可测集合被称为随机事件。

2.3 测度

测度(Measure):用一个函数,将某一个集合映射到一个非负数,这个数可以比作大小、体积、

概率等等。测度是一个函数。

传统的积分是在区间上进行的,后来人们希望把积分推广到任意的集合上,就发展出测度的概

念,它在数学分析和概率论有重要的地位,研究对象有 σ 代数、测度、可测函数和积分。

测度的数学定义如下:

定义2.3 测度:一个测度 µ(详细的说法是可列可加的正测度),设集合 F

1

的元素是集合 S 的子

集合,而且是一个 σ 代数,µ 在 F 上定义,值域为 [0, ∞),并且满足以下性质:

1. 空集合的测度为零:µ(∅) = 0

2. 可数可加性,或称 σ 可加性:E

1

, E

2

, ··· 为 P 中可数个两两不相交集合的序列,则所有 E

i

的并集的测度等于每个 E

i

的测度之和,即 µ(

S

∞

i=1

E

i

) =

P

∞

i=1

µ(E

i

)

这三个元素 (S, F, µ) 称为一个测度空间,P 中的某元素称为可测集合。在概率论中,测度空间

写作 (Ω, F, P ),称为概率空间

2

。

1

这里的集合 F 并不一定是指集合 S 的幂集,只是 S 的幂集 P (S) 的子集,P (S) 的子集的元素显然是 S 的子集。

2

概率空间(Ω, F, P ) 是一個总测度为 1 的测度空间(即 P (Ω) = 1)。

5

2 测度

2.4 概率测度

实际上,在概率论中概率并没有具体定义,符合 Kolmogorov 公理的事物被称为概率。

1 Kolmogorov 公理

定一个样本空间 Ω 以及相应的 σ 代数 F,函数 P : P → [0, 1] 若满足:

1. 非负性:对于任意的事件 A,若 A ∈ F,则 P (A) ⩾ 0。

2. 正则性:P (Ω) = 1。

3. 可列可加性:若 A

1

, A

2

, ···, A

n

, ··· 互不相容,则 P (

S

∞

i=1

A

i

) = Σ

∞

i=1

p(A

i

)。

则我们称 P 为概率函数或概率测度。

以上概率的定义通常称之为概率的公理化定义(Axioms of Probability),或者柯尔莫哥洛夫公

理(Kolmogorov Axioms)。

易知,概率测度满足测度的两个性质,概率测度的值域为 [0, 1] ∈ [0, ∞)。概率空间记作 (Ω, F, P )。

Ω 为样本空间,F 为样本空间的某些子集

3

组成的一个事件域(即 σ 域)。

从直观上讲,事件域就是 Ω 中某些子集及其运算(差、对立、并、交)结果而组成的集合类,记

为 F。

F 的定义如下:

设 Ω 为一样本空间,F 为 Ω 的某些子集所组成的集合类,如果 F 满足如下三个条件,则称 F

为一个事件域,又称为 σ 域或者 σ 代数。

1. Ω ∈ F

2. 若 A ∈ F,则

¯

X ∈ F

3. 若 A

n

∈ F, n = 1, 2, ···,则可列并 ∪

∞

n=1

A

n

∈ F

由上面的叙述已经知道测度的实质是一个函数,在概率空间中,该测度函数为概率,概率是一个

函数,满足概率空间三个条件的函数称之为概率。

2.4.1 条件概率

条件概率也属于概率,所以条件概率也满足概率测度的三个性质(条件),即对于条件概率

P (X|Y = y),有:

1. P (X|Y = y) ⩾ 0

2. P (Ω|Y = y) = 1

3. 若 X

1

, X2, ···, X

n

, ··· 互不相容(即 X

i

∩ X

j

̸= ∅, i ̸= j),有 P (

S

∞

i=1

X

i

|Y = y) =

Σ

∞

i=1

p(X

i

|Y = y)。

Note: 在构造条件概率时,我们就使其满足概率测度的要求,但巧妙的是任何一个概率

都可以看作条件概率,例如:P (A) = P (A|Ω)�

3

样本空间的子集并不是总是可测的,尽管在样本空间为可数的情况下定义概率函数相对简单,然而当我们考虑的

样本空间为不可列时,概率函数的定义变得尤为困难。例如当样本空间是实数轴上的一个区间的时候,可以人为地都

构造出无法测量其长度的子集。这样的子集称为不可测集。为了避免这种情况的出现,我们没有必要将连续样本空间

的所有子集都看成是事件,只需要把可测集看成是事件即可(我们只对可以测量的子集感兴趣)。

6

3 概率的公式

2.4.2 Borel 域

若我们关心的样本空间为 Ω = R,我们令 ϕ 为所有开区间的集合:ϕ = {(a, b)| − ∞ < a <

b < +∞},那么包含 ϕ 的最小 σ 代数称为 Borelσ代数 或 Borel 域。其中的元素成为 Borel 集

(Borelset)。

由于 (a, b] =

T

∞

i=1

(a, b +

1

i

),因而所有的左开右闭区间也都是 Borel 集。同理可证所有的左闭右

开区间 [a, b),闭区间 [a, b] 及其可数并、交都为 Borel 集。

2.4.3 勒贝格不可测集

上面有说到不是所有的样本空间的子集都是可测的,这里给出一个例子。

如果我们选取样本空间 Ω = [0 , 1],令 Ω 中的所有有理数集合为 Q

′

,由于有理数为可数集合,因

而可以写成 Q

′

= {q

1

, q

2

, ···}。对于 (0, 1) 之间的任意实数 a,定义集合

S

a

=

a + q if a + q < 1

a + q − 1 if a + q ≥ 1

∀q ∈ Q

′

那么可知 ∪

a∈[0,1]

S

a

= [0, 1]。由于,S

a

也是可数集,因而可以写成 S

a

= {S

a1

, S

a2

, ···}。

令 T

1

为所有 S

a

中的 s

a1

,T

2

为所有 S

a

中的 s

a2

,因而我们有可数个 T

k

,∪

∞

k=1

T

k

= [0, 1],

且 T

k

两两不相交。每个 T

k

地位相等因而 P (T k) = P (T k�)。若 P (T

k

) > 0,则:

1 = P ([0, 1]) = P (∪

∞

k=1

T

k

) = �

∞

k=1

P (T

k

) = ∞

若 P (T

k

) = 0,则:

1 = P ([0, 1]) = P (∪

∞

k=1

T

k

) = �

∞

k=1

P (T

k

) = 0

无论如何都会得到矛盾。

因而在概率论中,在仅仅给定样本空间的情况下,并非任意集合都可以确定其概率。我们一般将

上述性质不够良好的集合称之为(勒贝格)不可测集,而概率空间中 F 应该排除这些性质不够

良好的不可测集。

2.4.4 开集与闭集的概率

3 概率的公式

3.1 加法公式

对于任意 n 个事件 A

1

, A

2

, ··· , A

n

,有

P (

n

[

i=1

A

i

) =

n

X

i=1

P (A

i

)−

X

1≤i≤j≤n

P (A

i

A

j

)+

X

1≤i≤j≤k≤n

P (A

i

A

j

A

k

)+···+(−1)

n−1

P (A

1

A

2

···A

n

)

7

3 概率的公式

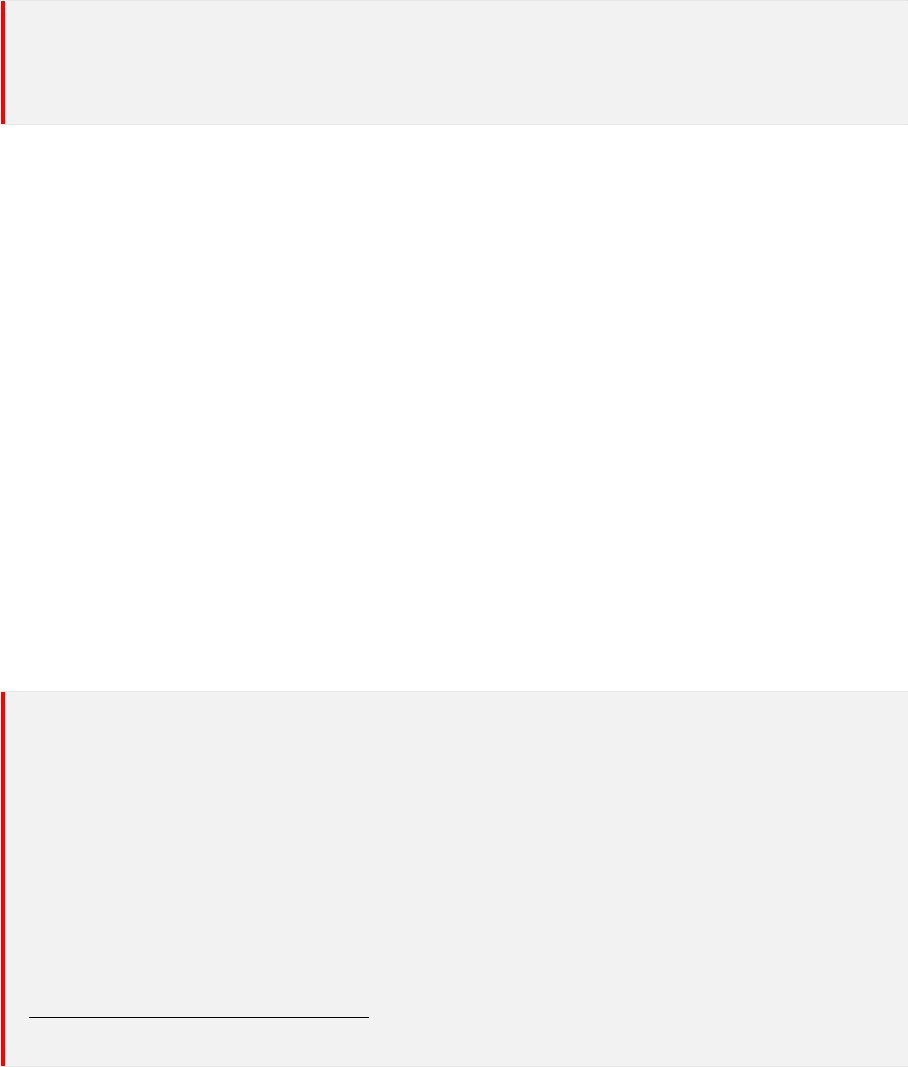

图 1: 条件概率

3.2 乘法公式

3.2.1 条件概率

Note: 乘法公式描述的是多个事件同时发生的概率。相对一般的乘法 A × B,概率论中

也有乘法这个名词,指的就是集合(事件集合)的交的概率。

说到乘法公式,不得不涉及到条件概率。

定义3.1 条件概率:若 A 与 B 是样本空间 Ω 中的两事件,若 P (B) > 0,则 P (A|B) =

P (AB)

P (B)

,

这就是条件概率。P (A|B) 称为 “在 B 发生下,A 的条件概率”。

Note: 为什么条件概率定义为两个概率的比例呢?在第6页中提到,任何概率都可以看作

条件概率。从频率的角度来解释:

P (B) =

N

B

N

Ω

P (AB) =

N

AB

N

Ω

P (A|B) =

N

AB

/N

Ω

N

B

/N

Ω

=

P (AB)

P (B)

也就是,公式中的 P (AB) 是以 P (Ω) 为基础的,P (B) 也是以 P (Ω) 为基础的,而 P (A|B) 则

是以 P (B) 为基础的。但是,这句话是什么意思呢?

要认识到条件概率的意义,必须要引入 “相关” 的概念。我们知道,许多事件是相关的,也就是

一个事件的发生会对另一个事件的发生有影响。从概率论的角度来说,就是一个事件是否发生

会影响另一个事件发生的概率。

举个例子:假设 A�B 事件是相关的,A 事件发生的概率为 P (A),B 事件发生的概率为 P (B)。

现在我们已经知道 A 事件发生了。根据我们先前的经验或研究,我们可以认为若 A 事件发生,

B 事件发生的可能性更大,记 B 事件此时发生的概率为 P (B

1

)。显然,P (B

1

) > P (B),我们已

有的概率 P (B) 已经没有意义,因为 P (B) 无法准确度量此时 B 事件发生的可能性。因此,引

入条件概率。

所以,我们可以知道,条件概率的意义就是对原有概率的修正。这和贝叶斯公式的意义是一样

的,因为接下来所说的贝叶斯公式本质就是一个条件概率。

3.2.2 乘法公式

乘法公式其实就是条件概率的变形,注意到 P (B) = 0 意味着条件概率是没有意义的,这里的没

有意义不仅仅指数学上除数不能为 0,更重要的是我们是不会因为一个概率为 0 的事件而对其

它事件发生的概率进行修正。就算两个事件相关,但是一个事件概率为 0,它又能起到什么影响

呢?

同样的,P (B) 为 0 的话,乘法公式也是没有意义的,虽然作乘法运算的数可以为 0。乘法公式

描述的是两个(多个)事件同时发生的概率,如果其中一个事件发生的概率为 0,那么多个事件

同时发生的概率难道不是 0 吗?

8

3 概率的公式

两事件的简单情形:若 P (B) > 0,则 P (AB) = P (A|B)P (B)

Note: 由条件概率就可以得到。如果 P (B) = 0(事件 B 不会发生),则 P (AB) = 0。

若 P (A

1

A

2

···A

n−1

) > 0,则

P (A

1

···A

n

) = P (A

1

)P (A

2

|A

1

)P (A

3

|A

1

A

2

) ···P (A

n

|A

1

···A

n−1

)

Note: 因为 A

1

⊃ A

1

A

2

⊃ A

1

A

2

A

3

⊃ ..... ⊃ A

1

A

2

...A

n−1

,所以 P (A

1

) ⩾ P (A

1

A

2

) ⩾

P (A

1

A

2

A

3

) ⩾ ..... ⩾ P (A

1

A

2

...A

n−1

) > 0

因此,上式右边的每个条件概率都是有意义的(即不为 0)。

P (A

1

)P (A

2

|A

1

)P (A

3

|A

1

A

2

).....P (A

n

|A

1

A

2

...A

n−1

) = P (A

1

) ·

P (A

1

A

2

)

P (A

1

)

·

P (A

1

A

2

A

3

)

P (A

1

A

2

)

· · ·

·

P (A

1

A

2

....A

n

)

P (A

1

A

2

....A

n−1

)

= P (A

1

, A

2

, ...A

n

)

3.3 全概率公式

描述的是多个交事件的概率。

假设 B

n

: n = 1, 2, 3, ... 是一个概率空间的有限或者可数无限的分割(既 B

n

为一完备事件组

4

),

且每个集合 B

n

是一个可测集合,P (B

i

) > 0,则对任意事件 A 有全概率公式:

P (A) =

X

n

P (A ∩ B

n

)

又因为,根据乘法公式有:P (A ∩ B

n

) = P (A | B

n

)P (B

n

)

此处 P (A|B) 是 B 发生后 A 的条件概率,所以全概率公式又可写作:

P (A) =

X

n

P (A | B

n

)P (B

n

)

3.4 贝叶斯公式

说实话,虽然贝叶斯的公式简单,用乘法公式和全概率公式就可以轻松推导出来,但是我是很久

以后才明白贝叶斯公式的意义。下面先给出贝叶斯公式的定义,相信只看定义和公式证明,很难

想到贝叶斯公式的含义,所以接下来还会给出解释。

在乘法公式和全概率公式的基础上,可建立贝叶斯公式。

【贝叶斯公式】假设 B

n

: n = 1, 2, 3, ... 是一个概率空间的有限或者可数无限的分割(既 B

n

为一

完备事件组),P (A) > 0�P (B

i

) > 0,则

P (B

i

|A) =

P (B

j

)P (A|B

j

)

P

n

i=1

P (B

i

)P (A|B

i

)

证明很简单,运用条件概率定义、乘法公式、全概率公式就可以推导出贝叶斯公式,所以这里就

不写证明过程了。

实际上,贝叶斯公式是一个条件概率,我想这么说应该没什么需要解释的,因为 P (B

i

|A) 就是

条件概率。所以有:

P (B

i

|A) =

P (B

i

A)

P (A)

4

理论上不需要完备也可以,但在实际中,一般认为是完备的。

9

3 概率的公式

条件概率的意义是对原有概率的修正,因此贝叶斯公式的本质也是对原有概率的修正。以上式

为例,就是对 P (B

i

) 的修正。

接下来,我们从贝叶斯公式的本质来推导贝叶斯公式。

∵ P (B|A) =

P (AB)

P (A)

∴ P (AB) = P (B|A)P (A)

同理有,P (AB) = P (A|B)P (B)

∴ P (B|A)P (A) = P (A|B)P (B)

P (B|A) =

P (A|B)P (B)

P (A)

(3.4)

如果,事件 B 可以分成许多个小事件 B

i

,而 B

i

构成了样本空间 Ω 的一个划分(至少)B 包含

A。那么,根据全概率公式有:P (A) =

P

n

P (A | B

n

)P (B

n

)。将这个代入 7 式,就可以得到贝

叶斯公式的一般形式。

对条件概率 3.4 式进行变形,可以得到如下形式:

P (B|A) = P (B)

P (A|B)

P (A)

= P (B)

P (AB)

P (A)P (B)

我们把 P (B) 称为” 先验概率”(Prior probability),即在 A 事件发生之前,我们对 B 事件概率

的一个判断。P (B|A) 称为” 后验概率”(Posterior probability),即在 A 事件发生之后,我们对

B

事件概率的重新评估。

P

(

A

|

B

)/

P

(

A

)

称为

”

可能性函数

”

(

Likely hood

),这是一个调整因子,

使得预估概率更接近真实概率。

所以,贝叶斯公式可以这样理解:后验概率 = 先验概率 x 调整因子

Note: 在这里,如果” 可能性函数”P(A|B)/P(A)>1,意味着” 先验概率” 被增强,事件

B 的发生的可能性变大;如果” 可能性函数”=1,意味着 A 事件无助于判断事件 B 的可能

性;如果” 可能性函数”<1,意味着” 先验概率” 被削弱,事件 B 的可能性变小。

” 可能性函数”=1,也就是意味着 A、B 事件独立,自然 A 事件无助于判断事件 B 的可能

性。

这就是贝叶斯推断的含义。我们先预估一个” 先验概率”,然后加入实验结果,看这个实验到底

是增强还是削弱了” 先验概率”,由此得到更接近事实的” 后验概率”。

通常,事件 A 在事件 B(发生)的条件下的概率,与事件 B 在事件 A(发生)的条件下的概率

是不一样的;然而,这两者是有确定的关系的,贝叶斯定理就是这种关系的陈述。贝叶斯公式的

一个用途在于通过已知的三个概率函数推出第四个。

在贝叶斯公式中,每个名词都有约定俗成的名称:

1. P (A|B) 是已知 B 发生后 A 的条件概率,也由于得自 B 的取值而被称作 A 的后验概率。

2. P (B|A) 是已知 A 发生后 B 的条件概率,也由于得自 A 的取值而被称作 B 的后验概率。

3. P (A) 是 A 的先验概率(或边缘概率)。之所以称为” 先验” 是因为它不考虑任何 B 方面

的因素。

4. P (B) 是 B 的先验概率或边缘概率。

3.5 总结

1. 乘法公式是求单个交事件的概率

2. 全概率公式是求多个个交事件之和的概率

10

4 独立与不相关

3. 贝叶斯公式是求一个逆概率(条件概率)

4 独立与不相关

独立与不相关明显是不同的东西,本质肯定就是它们的定义不同。

4.1 事件的独立性

定义4.1 两个事件的独立性:两个事件 A 和 B 是独立的当且仅当 P (AB) = P (A)P (B)。

实际上,在定义独立性之前,我们先对独立性有一个主观的期待。即,事件 A�B 的独立性是指,

事件 A 的发生,不影响事件 B 的发生。事件 A、B 的独立性是指,事件 A 的发生,不影响事

件 B 的发生。也就是说:若两个事件 A 和 B 是独立的,在 B 发生的条件下 A 发生的条件概

率和 A 的无条件概率一样,即

P (A|B) = P (A)

而根据条件概率的定义,有:

P (A|B) =

P (AB)

P (B)

= P (A)

从而有:

P (AB) = P (A)P (B)

这就是事件 A、B 独立的定义。

定义4.2 多个事件的相互独立:对 n 个事件 A

1

, A

2

, ··· , A

n

, 若下面 2

n

− n −1 个等式同时成立:

P (A

i

A

j

) = P (A

i

)P (A

j

), 1 ≤ i < j ≤ n; 第一部分

P (A

i

A

j

A

k

) = P (A

i

)P (A

j

)P (A

k

), 1 ≤ i < j < k ≤ n;

P (A

i

A

j

A

k

A

l

) = P (A

i

)P (A

j

)P (A

k

)P (A

l

), 1 ≤ i < j < k < l ≤ n;

···············

P (A

1

A

2

···A

n

) = (A

1

)P (A

2

) ···P (A

n

).

第二部分

则称 A

1

, A

2

, ··· , A

n

是相互独立的。

Note: 满足第一部分称为两两独立,两两独立同时满足第二部分则称为相互独立。

显然,对于两个事件来说,两两独立等价于相互独立。但多个事件的相互独立就不能用两

两独立来定义。举个例子,三个事件的相互独立应该定义如下:

对于 3 个事件 A, B, C, 若下面 4 个等式同时成立:

P (AB) = P (A)P (B),

P (AC) = P (A)P (C),

P (BC) = P (B)P (C),

(1)

P (ABC) = P (A)P (B)P (C), (2)

称 A, B, C 相互独立。

11

4 独立与不相关

4.2 试验的独立性

利用事件的独立性定义试验的独立性。

定义4.3 :假如 E

1

的任一结果(事件)、E

2

的任一结果、…、E

n

的任一结果都是相互独立的事

件,则称试验

E

1

、

E

2

、…、

E

n

相互独立。假如这

n

个试验还是相同的,则称其为

n

重独立重

复试验。如果在 n 重独立重复试验中,每次试验的可能结果为两个:A 或

¯

A,则称这种试验为

n 重伯努利试验。

4.3 随机变量的独立性

设 n 维随机变量 (X

1

, X

2

, · · ·X

n

) 的联合分布函数为 F (x

1

, x

2

, · · · , x

n

),随机变量 X

i

的边缘分

布函数为 F

i

(x

i

)。

若对于任意实数 x

1

, x

2

, · · ·x

n

有 F (x

1

, x

2

, · · ·, x

n

) = F

1

(x

1

)F

2

(x

2

) · · · F

n

(x

n

),则称随机变量

X

1

, X

2

, · · ·X

n

是相互独立的。

1. 在离散随机变量场合,如果对其任意 n 个取值 x

1

, x

2

, ···x

n

,有 P (X

1

= x

1

, ···, X

n

= x

n

) =

P (X

1

= x

1

) · · · P (X

n

= x

n

),则称随机变量 X

1

, X

2

, · · ·X

n

是相互独立的。

2. 在连续随机变量场合,如果对其任意 n 个实数 x

1

, x

2

, ···x

n

,有 f(x

1

, x

2

, ···, x

n

) =

n

Π

i=1

f

i

(x

i

),

则称随机变量

X

1

, X

2

,

· · ·

X

n

是相互独立的。

Note: 事件的独立性、试验的独立性、随机变量的独立性,三者的本质都是一样的,都

是基于分布(或者说概率)来定义的。(分布就是概率的描述)

4.4 线性相关性

设 (X, Y ) 是一个二维随机变量。若 E[X −E(X)][Y −E(Y )] 存在,则称它是随机变量 X 与 Y

的协方差,或称为 X 与 Y 的相关(中心)矩,并记为 cov(X, Y ) = E[X −E(X)][Y −E(Y )]。

1. 当 cov(X, Y ) > 0 时,称 X 与 Y 正相关

2. 当 cov(X, Y ) < 0 时,称 X 与 Y 负相关

3. 当 cov(X, Y ) = 0 时,称 X 与 Y 不相关

4.5 不相关与独立的关系

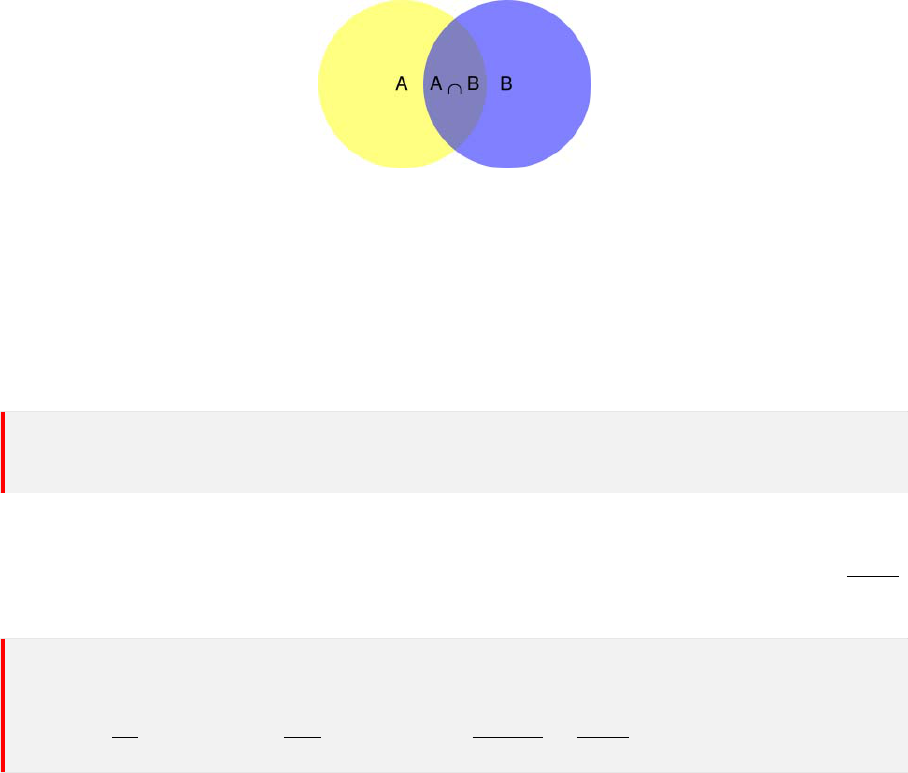

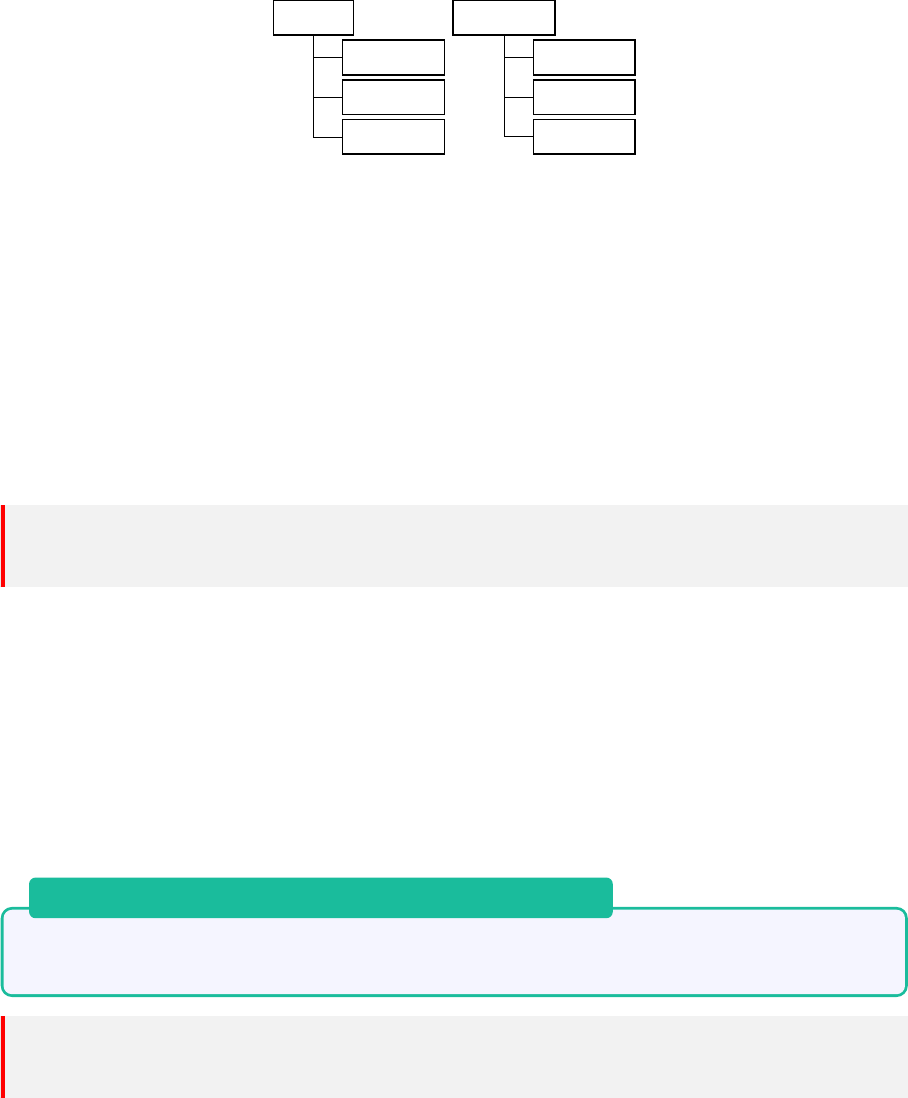

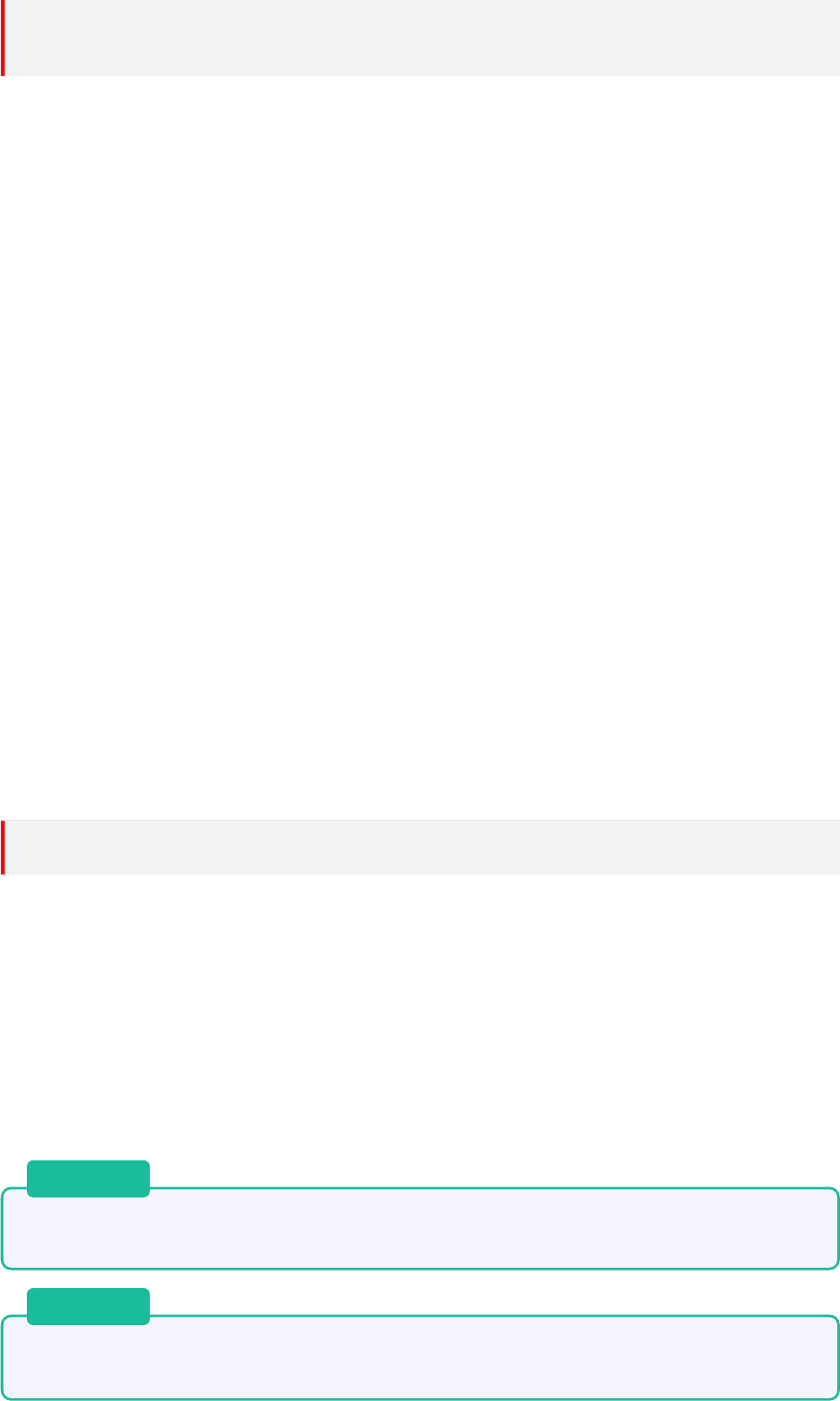

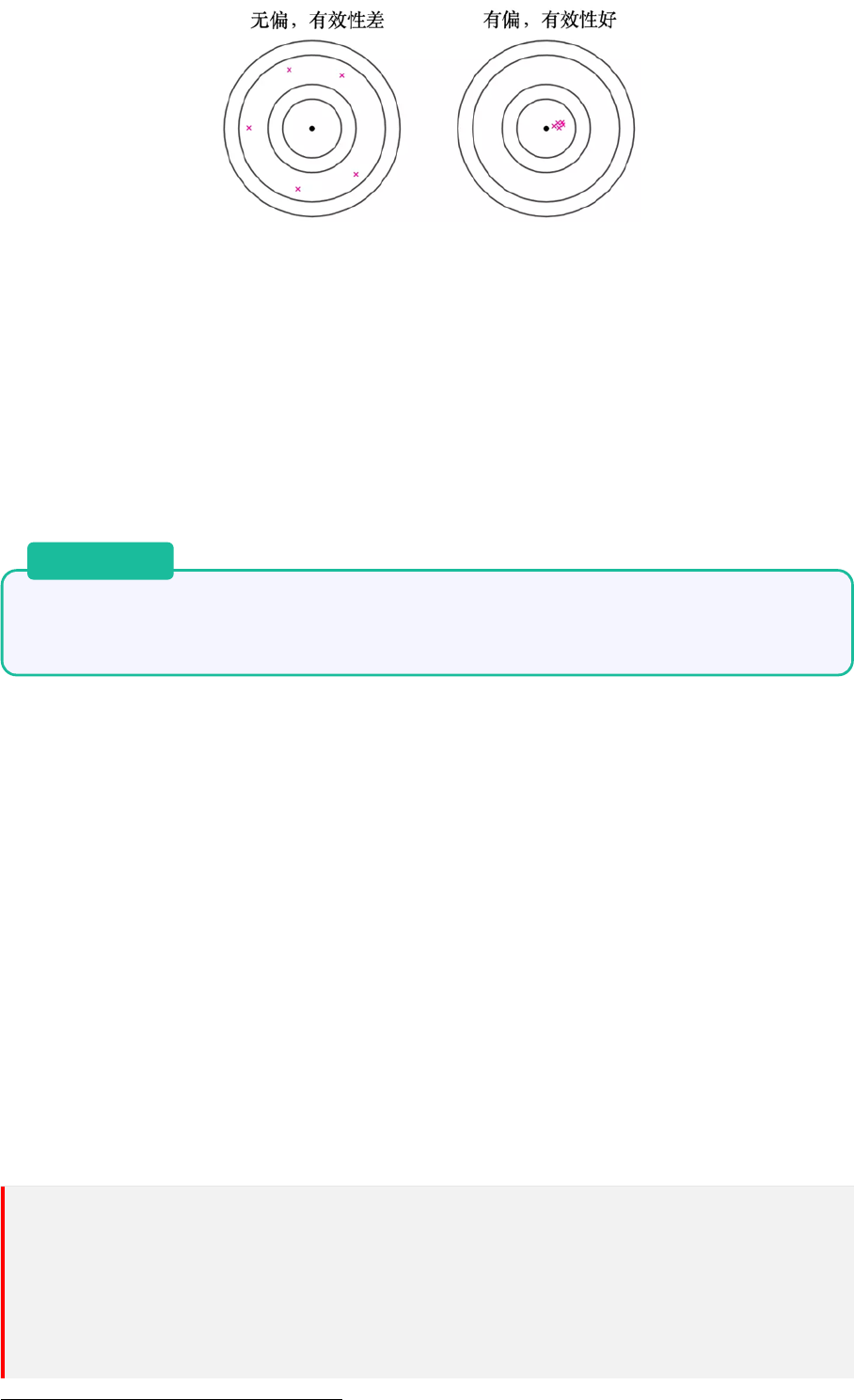

图 2: 不相关与独立

不相关是比独立更弱的概念,因为独立性是用分布定义的,而不相关只是用矩定义的,因此独立

性的要求更严,不相关要求较宽。因此有:

12

4 独立与不相关

若随机变量 X 与 Y 相互独立,则 cov(X, Y ) = 0,反之不成立。

证明.

cov(X, Y ) = E[X − E(X)][Y − E(Y )]

= E{XY − XE(Y ) − Y E(X) + E(X)E(Y )}

= E(XY ) − E(X)E(Y )

因此,若要证明 X�Y 相互独立,其协方差为 0,即证明若 X�Y 相互独立,则 E(XY ) = E(X)E(Y )。

因为 X�Y 相互独立,其联合密度函数与边缘密度函数满足 p(x, y) = p

X

(x)p

Y

(y),同时根据期

望的定义有:

E(XY ) =

+∞

Z

−∞

+∞

Z

−∞

(xy)p

X

(x)p

Y

(y)dxdy

=

+∞

Z

−∞

xp

X

(x)dx

+∞

Z

−∞

yp

Y

(y)dy = E(X)E(Y )

【反例】

设随机变量 X~N(0, σ

2

),且令 Y = X

2

,则 X 与 Y 不独立,此时二者的协方差为 Cov(X, Y ) =

Cov(X , X

2

) = E(X · X

2

) − E(X)E(X

2

) = 0。

13

4 独立与不相关

14

第二部分

基础概率论

15

5 随机变量

5 随机变量

Note: 为了进行定量的数学处理,必须把随机现象的结果数量化,因此需要引进随机变

量。随机变量概念的引进使得对随机现象的处理更加简单和直接。

随机变量是样本空间上的实值函数,由于是随机取值,所以伴随着一个分布。有没有分布是区分

一般变量与随机变量的主要标志。

随机变量用大写字母表示,小写字母表示其取值。

5.1 离散型随机变量

特征是只能取有限个值,或虽则在理论上讲能取无限个值,但这些值可以毫无遗漏地一个接一个

排列出来(可列的)。

5.2 连续型随机变量

变量的全部可能取值无穷多,并且还不能无遗漏地逐一排列,而是充满一个区间。例如秤量一物

体重量的误差,由于我们难于明确指出误差的可能范围,不妨就把它取为 (−∞, ∞) 更方便。又

如电视机的寿命,其范围可取为 (0, ∞),也是一种抽象。

说到底,“连续型变量” 这个概念只是一个数学上的抽象。任何量都有一定单位,都只能在该单

位下量到一定的精度,故必然为离散的。但是当单位极小时,其可能值在一范围内会很密集,不

如视为连续量在数学上更易处理。

6 概率分布

定义6.1 概率分布:是全面地(一个不漏)、动态地描述随机变量取值的概率规律。

6.1 分布函数(概率分布函数)

定义6.2

分布函数:

X

为

r.v.

�

∀

x

∈ R

,称

F

(

x

) =

P

(

X

≤

x

)

为

X

的分布函数,且称

X

服从

F (x),记为 X ∼ F (x)。有时也用 F

X

(x) 以表明是 X 的分布函数。

1. 离散型的分布函数:F (x) =

P

x

i

≤x

p(x

i

)

2. 连续型分布函数:F (x) =

R

x

∞

p(t)dt

F (x) 具有以下三条基本性质(判别分布函数的充要条件):

1. 单调性:F (x) 是一个单调不减的函数,即当 x

1

< x

2

时,F (x

1

) ≤ F (x

2

)。

Note: F (x

2

) − F (x

1

) = P (x

1

< X ≤ x

2

) ≥ 0

2. 有界性:0 ≤ F (x) ≤ 1,且 F (+∞) = lim

x→+∞

F (x) = 1, F (−∞) = lim

x→−∞

F (x) = 0。

证明. 因为 F (x) = P (X ≤ x),即 F (x) 是 X 落在 (−∞, x] 里的概率,所以 0 ≤ F (x) ≤ 1。

由 F (x) 的单调性可以知道,对于任意整数 m 和 n,有 lim

x→−∞

F (x) = lim

m→−∞

F (m)

3. 右连续性:F (x + 0) = lim

x→x

0

+

F (x) = F (x

0

),即 F (x) 是右连续的函数。

17

6 概率分布

Note: 同一样本空间上可以定义不同的随机变量,不同的随机变量可能有不同的分布函

数。

常用公式

P (a < X ≤ b) = F (b) − F (a)

P (X = a) = F (a) − F (a − 0)

P (X ≥ b) = 1 −F (b − 0)

P (X > b) = 1 −F (b)

P (a < X < b) = F (b − 0) − F (a)

P (a ≤ X ≤ b) = F (b) − F (a − 0)

P (a ≤ X < b) = F (b − 0) − F (a − 0)

6.2 分布列

定义6.3 分布列:设 X 是离散的 r.v.,若 X 的所有可能取值是 x

1

, x

2

, ··· , x

n

, ···,则称 X 取 x

i

的概率

p

i

= p(x

i

) = P (X = x

i

), i = 1, 2, ··· , n, ···

为 X 的概率分布列,或简称分布列。

分布列和密度函数一样需要满足非负性和正则性。

6.3 概率密度函数

定义6.4 概率密度: X ∼ F (x),若存在实数轴上的一个非负可积函数 p(x),使得对任意实数 x,

有

F (x) =

Z

x

−∞

p(t)dt

则称 p(x) 为 X 的概率密度函数,简称为密度函数,或称密度。

概率密度函数的基本性质

1. 非负性:p(x) > 0

2. 正则性:

R

∞

−∞

p(x)dx = 1(含有 p(x) 的可积性)

以上两条基本性质是密度函数必须具有的性质,也是确定某个函数能否成为密度函数的充要条

件。

“概率密度” 一词的由来 “密度密数” 这名词的来由可解释如下。取定一个点 X,则按分布函

数的定义,事件 {x < X ≤ x + h} 的概率(h>0 为常数),应为 F (x + h) − F (x)。所以,比

值

F (x+h)−F (x)

h

可以解释为在 x 点附近 h 这么长的区间 (x, x + h) 内,单位长所占有的概率。令

h → ∞ 则这个比的极限,即 F

′

(x) = f(x),也就是在 x 点处 (无穷小区段内)单位长的概率,

或者说,它反映了概率在 X 点处的 “密集程度”。你可以设想一条极细的无穷长的金属杆,总质

量为 1,概率密度相当于杆上各点的质量密度。

18

7 期望

6.4 总结

1. 离散随机变量的分布函数总是右连续的阶梯函数,而连续随机变量的分布函数一定是整个

数轴上的连续函数。前者显然,后者是因为对任意点 x 的增量 ∆x,相应的分布函数的增

量总有 F (x + ∆x) − F (x) =

R

x+∆x

x

p(x)dx −→ 0(∆ → 0)

2. 离散随机变量在其可能取值点上的概率不为 0,而连续随机变量在 (−∞, ∞) 上任一点 a

的概率恒为 0,这是因为 P (X = a) =

R

a

a

p(x)dx = 0。这表明,不可能事件的概率为 0,但

概率为 0 的事件(如 P (X = a) = 0)不一定是不可能事件。类似地,必然事件的概率为

1,但概率为 1 的事件不一定是必然事件。

3. 由于连续随机变量仅取一点的概率恒为 0,从而事件 {a ≤ X ≤ b} 中剔去 x = a 和 x = b,

不影响其概率。

4. 由于在若干点上改变密度函数 p(x) 的值并不影响其积分的值,从而不影响分布函数 F (x)

的值,这意味着一个连续分布的密度函数不唯一。例如

p

1

(x) =

(

1/a , 0 ≤ x ≤ a

0 , else

p

2

(x) =

(

1/a , 0 < x < a

0 , else

但这两个函数在概率意义上是无差别的,在此称 p

1

(x) 与 p

2

(x) 是 “几乎处处相等”,其意

义是:在概率论中可剔去概率为 0 的事件后讨论两个函数相等及其它随机问题。这就是概

率论与微积分的不同之处。

7 期望

定义7.1 期望:根据概率分布,我们以概率值为权重,加权平均所有可能的取值,来获得了该随

机变量的期望 (expectation):

E(x) =

Z

∞

−∞

xp(x)dx

要求

R

∞

−∞

|x|p(x)dx < ∞,即

R

∞

−∞

|x|p(x)dx 收敛。

数学期望在物理上的解释就是重心。概率 p(x

i

) 可看作点 x

i

上的质量密度,F (x) 看作质量在 x

轴上的分布,则 E(X) 就是该质量分布的重心所在的位置。

E(x) 是消除随机性的主要手段,它的本质是常数。

数学期望刻画了 X 的值总在 E(X) 周围波动,但无法反映出波动的大小。

7.1 期望的性质

1. X 是 r.v.,g(x) 是 X 的函数,E[g(x)] =

R

g(x)p(x)dx

2. E(c) = c

3. E(aX) = aE(X)

4. g

1

(x), g

2

(x) 是函数,E[g

1

(X) ± g

2

(X)] = E[g

1

(X)] ± E[g

2

(X)]

8 方差

方差表示分布的离散程度。方差越大,说明随机变量取值范围大。

定义8.1 方差:若随机变量 X

2

的期望 E(X

2

) 存在,则称偏差平方 (X − EX)

2

的数学期望

E(X − EX)

2

为 X 的方差,即:

19

8 方差

V ar(X) = E[(X−µ)

2

] =

Z

+∞

−∞

(x−µ)

2

f(x)dx

Note: 为什么方差存在的必要条件只是 E(X

2

) 存在?

对于所有的随机变量 X,都有 E(X − EX)

2

=

R

x

2

f(x)dx − (EX)

2

。E(X

2

) 存在显然就

是

R

x

2

f(x)dx 存在,同时 E(X

2

) 存在也保证了 E(X) 的存在。

为什么 E(X

2

) 存在也保证了 E(X) 的存在?见下面的证明。

定理

8.1

方差存在,则期望一定存在。

证明. 已知方差存在,即 E(x

2

) 存在,要证明 E(x) 存在。

因为 E(x

2

) 存在,即

R

∞

−∞

x

2

f(x)dx < ∞

又因为 x

2

+ 1 ≥ |x|,所以

R

∞

−∞

(x

2

+ 1)f(x)dx =

R

∞

−∞

x

2

f(x)dx + 1 ≥

R

∞

−∞

|x|f(x)dx

即数学期望存在。

实际上,这是高阶矩存在,低阶矩必存在的特殊情形。

方差的平方根称为标准差 (standard deviation, 简写 std)。常用 σ 表示标准差,X 的标准差记

为 σ(X) 或 σ

X

。

Note: 方差与标准差的区别

方差与标准差的差别主要在量纲上,标准差与随机变量、期望有相同的量纲,所以期望加

减标准差是有意义的。因此标准差更多地被选用。

8.1 方差的性质

1. V ar(X) = E(X

2

) − [E(X)]

2

2. V ar(c) = 0

3. V ar(aX + b) = a

2

V ar(X)

8.2 切比雪夫不等式

标准差(方差)表示分布的离散程度。标准差越大,随机变量取值偏离平均值的可能性越大。可

以计算一个随机变量与期望偏离超过某个量的可能性。比如偏离超过 2 个标准差的可能性。即

P (|X−µ| > 2σ)

定理 8.2. Chebyshev 不等式

对于任意随机变量 X,如果它的期望 EX、方差 V ar(X) 都存在,那么对于任意常数 ε > 0,

有

P (|X−µ| ≥ ε) ≤

σ

2

ε

2

或

P (|X−µ| < ε) ≥ 1 −

σ

2

ε

2

20

8 方差

证明. 设 X 是一个连续随机变量,p(x) 是它的概率密度,期望 EX = a。则:

P (|X − a| ≥ ϵ) =

Z

{X:|X−a|≥ϵ}

p(x)dx ≤

Z

{X:|X−a|≥ϵ}

(X − a)

2

ϵ

2

p(x)dx

≤

1

ϵ

2

Z

∞

−∞

(X − a)

2

p(x)dx

=

σ

2

ϵ

2

Note: 证明过程中用到了两次放大的技巧,第一次放大被积函数,第二次放大积分区域。

只在 |X − a| > ϵ 的区域积分,所以 (X − a)

2

/ε 必定大于 1。

证明第二个不等式会更困难,因此从第一个不等式入手。

在概率论中,事件 {|X −E(X)| ≥ ε} 称为大偏差,其概率 P {|X −E(X)| ≥ ε} 称为大偏差发生

概率。

Chebyshev 不等式给出了大偏差发生概率的上界。这个上界与方差成正比,方差愈大,上界越

大,即:该不等式告诉我们,X 与距离平均值越远,概率就越小。

Chebyshev 不等式让我们摆脱了对分布类型的依赖。

我们知道,方差为 0 意味着随机变量的值集中在一个点上面,而下述定理对此进行了说明。

定理 8.3

若随机变量 X 的方差存在,则 V ar(x) = 0 的充分必要条件是 X 几乎处处为常数,即

P (X = a) = 1 。

证明. 充分性:P (X = a) = 1 −→ V ar(x) = 0

必要性:

因为此时 V ar(X) = 0,所以期望 E(X) 存在。有:

{|X −E(X)| > 0} =

S

∞

n

=1

{|X −E(X)| ≤

1

n

}

P ({|X − E(X)| > 0}) = P (

∞

[

n=1

{|X −E(X)| ≤

1

n

})

=

∞

X

n

=1

(|X −E(X)| ≤

1

n

)

≤

∞

X

n=1

V ar(X)

(1/n)

2

= 0

所以,P ({|X − E(X)| > 0}) = 0,即有 P ({|X − E(X)| = 0}) = 1,即 P (X = E(X)) = 1

21

9 排列组合

9 排列组合

定理 9.1. 分类计数原理(加法原理)

完成一件事,有 n 类方法,第 i 类方式中有 n

i

种不同方法,那么完成这件事总共的方法

数为

X

n

i

定理 9.2. 分步计数原理(乘法原理)

完成一件事,需分成 n 个步骤,做第 i 步有 n

i

种方法,那么完成这件事的方法数为

Y

n

i

Note: 加法原理、乘法原理是数组数学的内容。他们是被证明成立的,并不是公理。这

里不给出证明过程。

注意:加法原理和乘法原理都要求事件之间不相关。

重复排列——有序的重复抽样

如果样本空间总数为 n,抽样 m 次,则总的抽样可能性为

n

m

排列——有序的非重复抽样

有序的非重复抽样又叫做排列 (permutation)。从 n 个样品中挑选 m 个,放入 m 个位置,

总可能性为

P

m

n

= n(n − 1) ···(n − m + 1) =

n!

(n − m)!

重复组合——无序的重复抽样

样本总数为 n 个,抽样 m 次,m 可以大于 n。

重复组合数的得出可以做如下考虑:将 n 个元素画成 n 个盒子,用 n + 1 根火柴棒示意。

如果第 i 个元素取过一次,则在此盒子中用 0 作一记号。

| ⃝ ⃝| |⃝| ······ | ⃝ ⃝ ⃝ |

上图意味着:第一个元素取过 2 次,,第二个元素取过 0 次,第三个元素取过 1 次,……,

第 n 个元素取过 3 次。因为一共取过 m 次,则一共有 m 个 0 和 n+1 个 1。如此,在所

有的 0 和 1 中,除了两端的两个 1 不能动之外,共有 n + m −1 个 0 和 1 可以随意放置。

因此,重复组合相当于在 n + m − 1 个位置任选 m 个位置放置 0,或者在 n + m − 1 个

位置中任选 n − 1 个位置放置 1。

C

n−1

m

+

n

−

1

= C

m

m+n−1

=

(m + n − 1)!

m!(n − 1)!

组合——无序的非重复抽样

无序的非重复抽样又叫做组合 (combination)

C

m

n

=

n(n − 1) ···(n − m + 1)

m!

=

n!

m!(n − m)!

22

10 一维离散分布

10 一维离散分布

10.1 二项分布

设某事件

A

在一次试验中发生的概率为

p

,现把这试验独立地重复

n

次。

A

在这

n

次试验中发

生的次数记为 X,X 可取 0, 1, …, n 等值。

为确定其概率分布,考虑事件 X = k。要这个事件发生,必须在这 n 次试验的原始记录 AA

¯

AA ···

¯

AA

中,有 k 个 A,n − k 个

¯

A。每个 A 有概率 p,而每个

¯

A 有概率 1–p。又因为 n 次试验独立,

即每次 A 出现与否与其它次试验的结果独立。由概率乘法定理给出:每个这样的原始结果序列

发生的概率为 p

k

(1 −p)

n−k

。又因为在 n 个位置中 A 可以占据任何 k 个位置,故一共有 C

k

n

种

可能。由此得出

P (X = k) = C

k

n

p

k

(1 − p)

n−k

k = 0, 1, ···, n

X 所遵从的概率分布称为二项分布,记为 B(n, p)。

Note:

1. 事件 A 在一次试验中发生的概率为 p,这个概率是不变的,也就是要求每次实验的

条件是稳定的。

2. 各次试验是独立的。

10.1.1 期望与方差的推导

P

(

X

=

k

) =

C

k

n

p

k

q

n−k

, k = 0 , 1, ··· , n; q = 1 − p

EX =

n

X

k=0

kC

k

n

p

k

q

n−k

=

n

X

k=1

kC

k

n

p

k

q

n−k

=

n

X

k=1

k

n!

k!(n − k)!

p

k

q

n−k

= np

n

X

k=1

k

(n − 1)!

(k − 1)!(n − k)!

p

k−1

q

(n−1)−(k−1)

= np

n

X

k=1

C

k−1

n−1

p

k−1

q

(n−1)−(k−1)

= np

C

0

n−1

p

0

q

n−1

+ C

1

n−1

p

1

q

n−2

+ ... + C

n−1

n−1

p

n−1

q

0

= np

∵ DX = EX

2

− (EX)

2

EX

2

=

n

X

k=1

k

2

n

k

p

k

q

n−k

, k = 0 , 1, ··· , n; q = 1 −p

=

n

X

k=1

k(k − 1) + k

n

k

p

k

q

n−k

23

10 一维离散分布

=

n

X

k=1

k(k − 1)

n

k

p

k

q

n−k

+

n

X

k=1

k

n

k

p

k

q

n−k

其中,

P

n

k=1

k

n

k

p

k

q

n−k

= EX = np

n

X

k=1

k(k − 1)

n

k

p

k

q

n−k

=

n

X

k=1

k(k − 1)

n!

k!(n − k)!

p

2

p

k−2

q

n−k

=

n

X

k=2

k(k − 1)

n!

k!(n − k)!

p

2

p

k−2

q

n−k

注:特别注意这里 k=1 时项为 0,所以可以从 k=2 开始计算。

上式 =

n

X

k=2

n(n − 1)(n − 2)!

(k − 2)!(n − k)!

p

2

p

k−2

q

[(n−2)−(k−2)]

= n(n − 1)p

2

n

X

k=2

(n − 2)!

(k − 2)!(n − k)!

p

k−2

q

[(n−2)−(k−2)]

= n(n − 1)p

2

n

X

k=2

n − 2

k − 2

p

k−2

q

[(n−2)−(k−2)]

= n(n − 1)p

2

∴ EX

2

= n(n − 1)p

2

+ np

∴ DX = EX

2

− (EX)

2

= np − np

2

= np(1 − p)

Note: 推导过程关键是利用二项式 [p + (1 − p)]

n

= 1,为了能利用该二项展开式需要掌

握凑的技巧,即把 k 提出去,凑成二项展开式的形式。而且要注意到,即使求和时 k 不从

0 开始,二项展开式也是从 0 次幂开始的。

10.1.2 二项分布期望与方差的简单推导

上面介绍了直接推导二项分布期望、方差的方法,如果借助二项分布的可加性(当然,二项分布

的可加性我们还没有叙述),很容易看出二项分布的期望与方差。

二项分布 X ∼ B(n, p) 中 X 表示的是 n 次伯努利试验中事件发生次数。用随机变量 X

i

表示

第 i 次伯努利试验的结果,那么 n 次伯努利试验总的随机变量 X 可以表示成:X = X

1

+ X

2

+

... + X

i

+ ... + X

n

。

根据均值和方差的性质,如果两个随机变量 X、Y 相互独立,那么:

E(X + Y ) = E(X) + E(Y )

D(X + Y ) = D(X) + D(Y )

对于二项分布 X ∼ B(n, p),每一次伯努利试验都相互独立,因此:

E(X) = E(X

1

) + E(X

2

) + ··· + E(X

n

) = p + p + ··· + p = np

D(X) = D(X

1

) + D(X

2

) + ··· + D(X

n

) = p(1 − p) + p(1 − p) + ··· + p(1 −p) = np(1 − p)

显然,负二项分布的期望与方差也能通过这种方式推导出来。

24

10 一维离散分布

10.1.3 名字由来

因为 C

i

n

p(1 − p)

n−i

恰好是二项式 (p + (1 − p))

n

展开式中的第 k+1 项。

实际生活中有许多现象程度不同地符合这些条件,而不一定分厘不差。例如,某厂每天生产 n 个

产品,若原材料质量、机器设备、工人操作水平等在一段时期内大体保持稳定,且每件产品之合

格与否与其他产品合格与否并无显著关联,则每日的废品数 X 大体上服从二项分布。

又如一大批产品 N 个,其废品率为 p,从其中逐一抽取产品检验其是否废品,共抽 n 个。若每

次抽出检验后又放回且保证了每次抽取时,每次每个产品有同等的

1

N

的机会被抽出,则这 n 个

产品中所含废品数

X

就相当理想地遵从二项分布了。反之,如果每抽出一个检验后即不放回去,

则 下一次抽取时,废品率已起了变化,这时 X 就不再服从二项分布了。但是,若 N 远大于 n,

则即使不放回,对废品率影响也极小,这时,X 仍可近似地作为二项分布来处理。

10.2 伯努利分布(0 − 1 分布)

伯努利分布 (Bernoulli distribution) 是很简单的离散分布。在伯努利分布下,随机变量只有两个

可能的取值:1 和 0。随机变量取值 1 的概率为 p。相应地,随机变量取值 0 的概率为 1 − p。

很显然,伯努利分布是二项分布的特例。n = 1 时的二项分布称为伯努利分布。其分布列为

p(X = k) = p

k

(1 − p)

1−k

, k = 1, 0

10.3 泊松分布

法国数学家 poisson 在 1837 年首次提出泊松分布。

泊松分布 (Poisson distribution) 是二项分布的一种极限情况,当 成功概率p→0, 试验次数n→+∞

而 np = λ 时,二项分布趋近于泊松分布。这意味着我们进行无限多次试验,每次成功概率无穷

小,但 n 和 p 的乘积是一个有限的数值。Poisson 分布起源于 Poisson 对二项分布的极限研究。

二项分布是离散型机率模型中最有名的一个,其次是 Poisson 分布。Poisson 分布大多用于描述

一定的时间或空间内出现的事件个数。

通过下面的例子来阐释泊松分布产生的机制。

10.3.1 推导泊松分布

设有一段时间被我们所观察,同时设这段时间为 [0, 1),取一个很大的自然数 n,把时间 [0, 1) 分

成等长的 n 份。即:l

1

[0,

1

n

), l

2

[

1

n

,

2

n

), ··· , l

n

[n − 1, 1)。

作几个假定:

1. 在每段 l

i

内,恰发生一个 A 事件的概率近似地与这段时长

1

n

成正比,即可以取为 λ

1

n

。

2. 又假定 n 很大,所以

1

n

很小,以至于在 l

i

这么短的时间内发生两次 A 事件的概率几乎为

0。因此,在每段 l

i

内不发生 A 事件的概率为 1 − λ

1

n

。

3. 每段 l

i

是否发生 A 事件是独立的。

按照上述假定,[0, 1) 内发生的 A 事件数 X 服从二项分布,于是

P (X = k) = C

k

n

(

λ

n

)

k

(1 −

λ

n

)

n

−

k

很显然,上式只是近似成立而非严格等式。但是,当 n → ∞ 的时候,就会严格成立。当 n → ∞

时,有

C

k

n

n

k

→

1

k!

,(1 −

λ

n

)

n

→ e

−λ

。因此,可以知道 P (X = k) = C

k

n

(

λ

n

)

k

(1 −

λ

n

)

n−i

的极限为

25

10 一维离散分布

i

k!

e

−k

。这被称为泊松定理,推导过程入下:

由上面的叙述可知推导的已知条件有:

1. p =

λ

n

,也就是 λ = np

2. n → ∞

lim

n→∞

P (X = k) = lim

n→∞

n

k

p

k

(1 − p)

n−k

= lim

n→∞

n!

(n − k)!k!

λ

n

k

1 −

λ

n

n−k

= lim

n→∞

n!

n

k

(n − k)!

| {z }

F

λ

k

k!

1 −

λ

n

n

| {z }

→exp(−λ)

1 −

λ

n

−k

| {z }

→1

= lim

n→∞

1 −

1

n

1 −

2

n

. . .

1 −

k − 1

n

| {z }

→1(一共 k 项相乘)

λ

k

k!

1 −

λ

n

n

| {z }

→exp(−λ)

1 −

λ

n

−k

| {z }

→1

=

λ

k

k!

exp (−λ)

lim

n→∞

1

−

λ

n

n

= e

−λ

lim

n→∞

(1 −

λ

n

)

n

= lim

n→∞

[(1 +

1

n

−λ

)

n

−λ

]

−λ

= e

−λ

lim

n→∞

n!

n

k

(n − k)!

= lim

n→∞

n(n − 1)(n − 2) ···(n − k + 1)

n

k

= 1

综上所述,泊松分布的分布列为:

P (X = k) =

λ

k

k!

e

−λ

一般地说,若 X ∼ B(n�p),其中 n 很大,p 很小而 np = 不太大时,则 X 的分布接近于泊松

分布 P ()。这个事实在所述条件下,可将较难计算的二项分布转化为泊松分布去计算。

10.3.2 泊松分布期望和方差的推导

求 EX

when k = 0, k ·

λ

k

e

−λ

k!

= 0

∴ E(X) =

∞

X

k=1

k ·

λ

k

e

−λ

k!

E(X) =

∞

X

k=1

k ·

λ

k

e

−λ

k!

=

∞

X

k=1

λ

k

e

−λ

(k − 1)!

=

∞

X

k=1

λ

k−1

λe

−λ

(k − 1)!

= λe

−λ

∞

X

k=1

λ

k−1

(k − 1)!

in T aylor series, e

x

= 1 + x +

x

2

2!

+

x

3

3!

+ ... +

x

n

n!

+ ... =

∞

X

k=1

x

k−1

(k − 1)!

∴ E(X) = λe

−λ

∞

X

k=1

λ

k−1

(k − 1)!

= λe

−λ

e

λ

= λ

求 DX

26

10 一维离散分布

E(X

2

) =

∞

X

k=0

k

2

·

λ

k

e

−λ

k!

= λe

−λ

∞

X

k=1

kλ

k−1

(k − 1)!

= λe

−λ

∞

X

k=1

(k − 1 + 1)λ

k−1

(k − 1)!

= λe

−λ

(

∞

X

m=0

m · λ

m

m!

+

∞

X

m=0

λ

m

m!

)(m = k − 1)

= λe

−λ

(λ ·

∞

X

m=1

λ

m−1

(m − 1)!

+

∞

X

m=0

λ

m

m!

)

= λe

−λ

(λe

λ

+ e

λ

)

= λ(λ + 1)

∴ D(X) = E(X

2

) − (E(X))

2

= λ(λ + 1) − λ

2

= λ

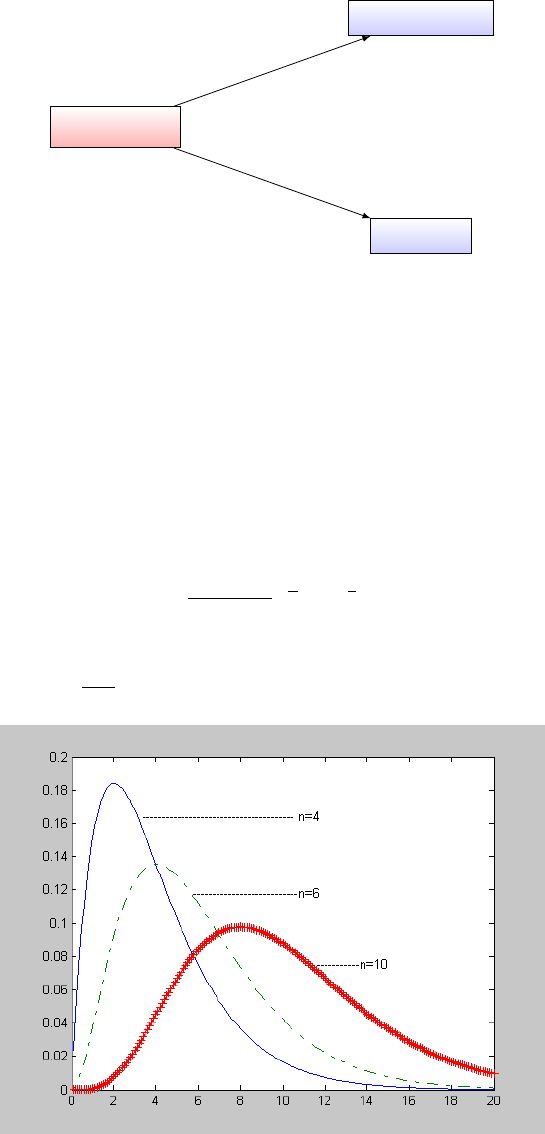

Note:

1. 位于均值 λ 附近概率较大。

2. 随着 λ 的增大,分布逐渐趋于对称。

10.3.3 poisson 分布的由来

5

poisson 分布由 Simeon D. Poisson 最先得到。Simeon D. Poisson(1781~1840 年)是一个著名

的法国数学家及物理学家。到了晚年,他热衷于将数学的机率论用到司法的运作上。他在这方面

的主要著作是 1837 年出版的《司法机率的研究》(Recherches sur la Probabilité des Jugements)。

虽然这本书的主旨是要对司法运作有具体的贡献,但它包含了许多纯粹数学的、机率的理论,所

以可以看成是一本以司法应用为例的机率课本,这本书德文版的书名《机率论及其重要应用》看

起来和内容较为一致。在这本书的数学推演中,Poisson 从二项分布的极限得到了这个日后以他

为名的概率分布。

Poisson 虽然得到这样的机率分布,但在书中他并没有继续讨论这种分布的性质,在往后的研究

中,Poisson 似乎也把它忘掉了。

Poisson 分布虽然出于 Poisson 之手,但真正使它为人重视,使它成为统计学一部分的却是

Bortkiewicz。

直到十九世纪末,Bortkiewicz 才注意到 Poisson 分布与某些数据之间也有类似的关联。他写了

一本小册子《小数法则》(Das Gesetz der Kleinen Zahlen),专门研究 Poisson 分布。他不但在

理论方面推演了 Poisson 分布的许多性质,并且在应用方面,也比较了一些实际发生的、有关于

自杀或意外伤害的数据。

10.4 超几何分布

一批产品共 N 个,其中废品 M 个。现从中随机 取出 n 个,问 “其中恰好 m 个废品” 这个事件

A 的概率是多少?

以 X 记从 N 个产品中随机抽出 n 个里面含废品数。按该例的计算,X 的分布为

5

引用自曹亮吉《Poisson 分布》

27

10 一维离散分布

P (X = m) =

C

m

M

C

n−m

N−M

C

n

N

, 0 ≤ m ≤ M, 0 ≤ n − m ≤ N − M

该分布称为超几何分布,是因为其形式与 “超几何函数” 的级数展式的系数有关。

这个分布在涉及抽样的问题中常用,特别当 N 不大时。因为通常在抽样时,多是像在本例中这

样 “无放回的”,即已抽出的个体不再有放回去以供再次抽出的机会,这就与把 n 个同时抽出的

效果一样。如果一个一个地抽而抽出过的仍放回,结果是二项分布。若

n

N

很小,则放回与不放

回差别不大。由此可见,在这种情况下超几何分布应与二项分布很接近。确切地说,若 X 服从

超几何分布,则当 n 固定,

M

N

= p 固定,N → ∞ 时,X 近似地服从二项分布。

10.4.1 超几何分布的期望和方差

准备公式:C

0

n

C

k

m

+ C

1

n

C

k−1

m

+ C

2

n

C

k−2

m

+ ··· + C

k

n

C

0

m

= C

k

n+m

; n, m, k ∈ N

∗

; k ≤ n, k ≤ m

利用恒等式 (1 + x)

n+m

= (1 + x)

n

(1 + x)

m

的二项展开式的系数相等便可以证明上式。

EX=

m

X

k=0

k

C

k

M

C

n−k

N−M

C

n

N

=

m

X

k=1

C

k−1

M

C

n−k

N−M

C

n

N

=

M

C

n

N

m

X

k=1

C

k−1

M−1

C

n−k

N−M

=

M

C

n

N

C

m−1

N−1

= n

M

N

EX

2

=

m

X

k=0

k

2

C

k

M

C

n−k

N−M

C

n

N

=

m

X

k=1

k

2

C

k

M

C

n−k

N−M

C

n

N

=

m

X

k=2

k(k − 1)

C

k

M

C

n−k

N−M

C

n

N

+ n

M

N

=

M(M − 1)

C

n

N

m

X

k=2

C

k−2

M−2

C

n−k

N−M

+ n

M

N

=

M(M − 1)

C

n

N

C

n−2

N−2

+ n

M

N

=

M(M − 1)n(n − 1)

N(N − 1)

+ n

M

N

DX = EX

2

− (EX)

2

=

nM(N − M )(N − n)

N

2

(N − 1)

10.5 负二项分布(帕斯卡分布)

为了检查某厂产品的废品率大小,有两个试验方案可采取:

1. 从该厂产品中抽出若干个,检查其中的废品数 X,这一方案导致二项分布。

2. 先指定一个自然数 r,一个一个地从该厂产品中抽样检查,直到发现第 r 个废品为止。以

28

10 一维离散分布

X 记到当时为止已检出的合格品个数。显然,若废品率 p 小,则 X 倾向于取较大之值,反

之当,p 大时,则 X 倾向于取小值。故 X 可用于考究 p。这一方案导致负二项分布。

为计算 X 的分布,假定每次抽取的结果(是废品或否)时独立的,且每次抽得废品的概率保持

固定,为 p。考察 X=i 这个事件,为使这个事件发生,需要以下两个事件同时发生:

1. 在前 i − 1 次抽取中,恰有 r − 1 个废品

2. 第 i 次抽取出废品

这两个事件的概率分别为 b(r − 1; i − 1; p) 和 p。因为这两个事件是独立的,两事件同时发生的

概率等于两事件的概率乘积。

P (X = i)= b(r − 1; i + r −1; p) ∗ p

= C

r−1

i−1

p

r−1

(1 − p)

i−r

∗ p

= C

r−1

i−1

p

r

(1 − p)

i−r

由几何分布的无记忆性,负二项分布实际可以看做 r 个几何分布之和:X = X

1

+X

2

+···+X

r

∼

Nb(r, p),其中诸 X

i

∼ Ge(p) 独立同分布。

10.5.1 名字由来

由于负指数二项展开式

(1 − x)

−r

=

∞

X

i=0

C

i

−r

(−x)

i

=

∞

X

i=0

C

i

i+r−1

x

i

=

∞

X

i=0

C

r−1

i+r−1

x

i

令 x = 1 − p,并令两边乘以 p

r

,得

1 = p

r

[1 − (1 − p)]

−r

=

∞

X

i=0

C

r−1

i+r−1

p

r

(1 − p)

i

这就验证了密度函数的非负性和正则性。另外,也由于例中所描述的试验方式,它与二项分布比

是 “反其道而行之”;二项分布是定下总抽样个数 n 而把废品个数 X 作为变量;负二分布则相

反,它定下废品个数 r 而把总抽样次数减去 r 作为变量。

10.6 几何分布

特别地,当 r = 1 时,负二项分布变为

P (X = i) = p(1 −p)

i

必定在最后一次抽出废品(成功),而前面的都是正常品,所以排序只有一种。

几何分布具有无记忆性,这是由于每次试验都是独立的试验,不受之前试验结果的影响。因为几

何分布描述的是第一次成功发生在第 X 次的概率,而几何分布基于伯努利试验,伯努利试验的

概率是稳定的。

10.6.1 几何分布的期望和方差

EX =

∞

X

k=1

kpq

k−1

= p

∞

X

k=1

kq

k−1

= p

∞

X

k=1

dq

k

dq

= p

d

dq

(

∞

X

k=0

q

k

) = p

d

dq

(

1

1 − q

) =

p

(1 − q)

2

=

1

p

29

11 各一维离散分布的联系

E(X

2

) =

+∞

X

k=1

k

2

pq

k−1

= p[

+∞

X

k=1

k(k − 1)q

k−1

+

+∞

X

k=1

kq

k−1

]

= pq

+∞

X

k=1

k(k − 1)q

k−2

+

1

p

= pq

+∞

X

k=1

d

2

q

k

dq

2

+

1

p

= pq

d

2

dq

2

(

+∞

X

k=0

q

k

) +

1

p

= pq

d

2

dq

2

(

1

1 − q

) +

1

p

= pq

2

(1 − q)

3

+

1

p

=

2q

p

2

+

1

p

V ar(X) = E(X

2

) − (EX)

2

=

2q

p

2

+

1

p

−

1

p

2

=

1 − p

p

2

推导二项分布的期望与方差的时候,利用了二项式定理,而这里利用了求导(求导和求和交换次

序)和拆项(k+1-1)。

10.6.2 几何分布的无记忆性

定理 10.1. 几何分布的无记忆性

X ∼ Ge (p),则对任意的正整数 m, n,有 P (X > m + n|X > m) = P (X > n)。

即:在前 m 次未出现 A 的情形下,接下来 n 次试验中仍未出现 A 的概率只与 n 有关而与 m

无关。

证明. 用条件期望公式和等比数列求和公式即可证明。

几何分布的无记忆性可与负二项分布作对比。

10.6.3 名字由来

概率 p, p(1 − p), p(1 − p)

2

, ··· 呈公比作为 1 − p 的几何级数。

11 各一维离散分布的联系

二项分布、几何分布、负二项分布都是基于独立的伯努利试验。

二项分布:描述在给定的 n 次试验中成功 X 次的概率;描述有限总体的放回抽样问题,或者无

限总体的抽样问题。

超几何分布:描述有限总体的无放回抽样问题。

泊松分布:二项分布的特例,描述在某个单位内(如:单位时间、单位面积、单位产品······)

上,事件的具体发生概率。

几何分布:描述第一次成功发生在第 X 次的概率,也就是描述首次成功所需试验次数的概率分

布情况。

负二项分布:描述第 r 次成功发生在第 x 次的概率,也就是描述成功 r 次,所需的试验次数的

概率分布情况。

30

12 一维连续分布

11.1 总结

1. 几何分布是 r = 1 的负二项分布特例。

2. 伯努利分布是二项分布 n = 1 时的特例。

3. 独立的伯努利分布的随机变量之和服从二项分布。

4. 独立的几何分布的随机变量之和服从负二项分布。

5. 泊松分布是二项分布 n → ∞ 时的特例。

12 一维连续分布

12.1 正态分布(Gauss 分布)

高斯在研究误差理论的时候,首先用正态分布来刻画误差的分布。

对于具有以下密度函数的随机变量 X,我们称其服从正态分布 (Normal Distribution)(或高

斯分布 (Gauss Distribution)),记作 X ∼ N (µ, σ

2

)。

p(x) =

1

σ

√

2π

e

−

(x−µ)

2

2σ

2

正态分布具有以下性质:

1. 期望 µ,方差 σ

2

2. p(x) 是关于 x = µ 对称的一条钟形曲线,在对称轴处达到最大值。µ ± σ 是曲线的拐点

3. 如果固定 σ 只改变 µ,p(x) 图形仅作平移而形状不变,因此称 µ 为位置参数

4. 如果固定 µ 只改变 σ,p(x) 图形分布的集中程度改变(σ 越大,图形越 “矮胖”),称 σ 为

尺度参数

5. 3σ 原则:绝大部分的值落在 µ±3σ 的范围内(这是根据正态分布函数算出来的,而不是切

比雪夫不等式)

P (|X − µ| < kσ) =

0.6826, k = 1 ,

0.9545, k = 2 ,

0.9973, k = 3 .

12.1.1 标准正态分布

将 N(0, 1) 称为标准正态分布 (Standard Normal Distribution),其密度函数记为 (x),分布

函数记为 (x)。

标准化:如果 X ∼ N(µ, σ),那么 U =

X−µ

σ

∼ N(0, 1)

12.1.2 正态分布的期望和方差

E(X) =

Z

+∞

−∞

x ·

1

√

2πσ

e

−

(x−µ)

2

2σ

2

dx

=

1

√

2πσ

Z

+∞

−∞

(x − µ)e

−

(x−µ)

2

2σ

2

dx +

1

√

2πσ

Z

+∞

−∞

µe

−

(x−µ)

2

2σ

2

dx

=

1

√

2πσ

Z

+∞

−∞

te

−

t

2

2σ

2

dt + µ

Z

+∞

−∞

1

√

2πσ

e

−

(x−µ)

2

2σ

2

dx

31

12 一维连续分布

= 0 + µ

= µ

12.2 均匀分布

若随机变量 X 的密度函数为以下 p(x):

p(x) =

1

b − a

, a < x < b,

0, otherwise.

, F (x) =

0, x < a,

x − a

b − a

, a ≤ x < b,

1, x ≥ b.

那么称 X 服从区间 (a, b ) 上的均匀分布 (Uniform Distribution),记作 X�U (a, b)。其分布函

数如上述的 F (x)。其期望是区间中点 EX =

a+b

2

,方差为 V ar(X) =

(b−a)

2

2

。

12.2.1 名字的由来

均匀分布这个名称的来由很明显。因为密度函数 f 在区间 [a�b] 上为常数,故在这区间上,概率

在各处的密集程度一样。或者说,概率均匀地分布在这区间上。

12.3 指数分布与其无记忆性

X 服从指数分布 (Exponential Distribution),记为 X�Exp():

p(x) =

(

λe

−λx

, x ≥ 0,

0, x < 0.

, F (x) =

(

1 − e

−λx

, x ≥ 0,

0, x < 0.

其期望

EX

=

1

λ

,方差 V ar(X) =

1

λ

2

。指数分布是非负的,因此常常被用作元件寿命的分布;在

可靠性与排队论中也有应用。

其他性质:

1. 指数分布的无记忆性:P (X > s + t|X > s) = P (X > t),很容易证明。

2. 泊松分布与指数分布的关系:例如,在时段 [0, t] 内某机器故障的次数 N (t)�P (t),那么连

续两次故障之间的时间间隔 T �Exp()。

指数分布常用来作各种 “寿命” 分布的近似【所有不是由于自身的原因、自身的磨损、

自身的损耗(或者自身的损耗很慢)而引起的损坏,即损坏由意外引起的东西的寿命

服从指数分布】,如某些电子元件的寿命服从指数分布。

统计学中常称指数分布为 “永远年青” 的分布。

12.3.1 负指数一词的由来

�>0,x>0。e

−λx

总为负值,由于这个原因,指数分布也称为负指数分布。

12.4 Weibull 分布

若考虑老化,则应取失效率随时间而上升,不能为常数,而应 取为一个 x 的增函数,例如 λx

m

,

对某个常数 λ > 0, m > 0,在这个 条件下,按上例的推理,将得出:寿命分布 F (x) 满足微分方

程 F

′

(x)/[1 − F (x)] = λx

m

,此与初始条件 F (0) = 0 结合,得出

32

12 一维连续分布

F (x) = 1 −e

−(λ/m+1)x

m+1

取 a = m + 1(a > 1),并把 λ/(m + 1) 记为 λ,得出

F (x) = 1 −e

−λx

a

, x > 0

而 F (x) = 0 当 x < 0,此分布之密度函数为

f(x) =

(

λax

a−1

e

−λx

a

, x > 0

0 , x ≤ 0

上两式分别称为威布尔分布函数和威布尔密度函数。它 与指数分布一样,在可靠性统计分析中

占重要的地位。实际上指数分布是威布尔分布当 a = 1 时的特例。

12.5 伽马分布

X 服从伽马分布 (Gamma Distribution),记为 X�Ga(α, λ):

p(x) =

(

λ

α

Γ(α)

x

α−1

e

−λx

, x ≥ 0,

0, x < 0.

其中 Γ(α) =

R

∞

0

x

α−1

e

−x

dx, α > 0,称为伽马函数。伽马函数有如下的性质:

1. Γ(1) = 1, Γ(

1

2

) =

√

π

2. Γ(α + 1) = αΓ(α)

3. 当 n 为自然数时,有:Γ(n + 1) = nΓ(n) = n!

当 α = 1 时,e

−x

就是参数 λ = 1 的指数分布,所以显然 Γ(1) = 1。

12.5.1 伽马分布的性质

1. 期望 EX =

α

λ

,方差 V ar(X) =

α

λ

2

2. 当 0 < α�1,密度函数是严格下降的;当 1 < α �2,密度函数是先上凸后下凸的单峰函数;

当 α > 2,密度函数仍单峰,先下凸、再上凸、最后下凸

3. � 越大,它越接近正态分布;但它始终是偏峰函数

12.5.2 伽马分布的两个特例

• 当 = 1 时,伽马分布就是指数分布;

• 当 α = n/2, λ = 1/2 时,伽马分布是自由度为 n 的卡方分布 (Chi-square Distri-

bution),记为 X�2(n)。这里 n 可以是任意正实数,但通常取正整数。其期望与方差:

EX = n, V ar(X) = 2n

12.6 贝塔分布

Be(a, b) =

Γ(a + b)

Γ(a)Γ(b)

x

a−1

(1 − x)

b−1

, 0 < x < 1

期望 EX =

a

a+b

,方差

ab

(a+b)

2

(a+b+1)

。

33

13 随机变量函数的分布

13 随机变量函数的分布

离散随机变量在分布列的基础上直接计算即可,以下主要讨论连续随机变量。

对于连续型的随机变量,有两种方法:

1. 分布函数法

2. 定理法

13.1 分布函数法

直接由 Y 的分布函数 F

Y

(y) = P (g(X) ≤ y) 出发,按函数 g(x) 的特点作个案处理。

13.1.1 步骤

已知 X ∼ p

X

(x),要求 Y = f(X) 的分布密度 P

Y

(y)

1. 先求分布函数:F

Y

(y) = P (Y ≤ y) = P (f(X) ≤ y) = P (X ∈ C

y

) =

R

C

y

p

X

(x)dx,其中

C

y

= {x|f(x) ≤ y}。

2. 再求密度函数:p

Y

(y) = F

′

Y

(y) =

dF

Y

(y)

dy

下面直接给出一个例子来说明 “分布函数法” 的应用。

【例题】设 X ∼ exp(1),求 Y = X

2

的概率密度。

解:X ∼ p

X

(x) =

(

e

−x

x > 0

0 else

当 y > 0

F

Y

(y) = P (Y ≤ y) = P (X

2

≤ y) = P (−

√

y ≤ X ≤

√

y) =

R

√

y

−

√

y

p

X

(x)dx =

R

√

y

0

e

−x

dx

从而 p

Y

(y) = F

′

Y

(y) = (

R

√

y

0

e

−x

dx)

′

= e

−

√

y

·

1

2

√

y

所以 p

Y

(y) =

(

e

−

√

y

2

√

y

y > 0

0 else

13.2 定理法

定理 13.1

设 X 是连续随机变量,其密度函数为 p

X

(x),Y = g(X) 是另一个随机变量,若 y = g(x)

严格单调,其反函数 h(y) 有连续导数,则 Y = g(X) 的密度函数为

p

Y

(y) =

(

p

X

[h(y)] · |h

′

(y)|, a < y < b

0, otherwise.

其中 a = min{g(−∞), g(+∞)}, b = max{g(−∞), g(+∞)}

推断13.1 设 X ∼ p

X

(x), Y = kX + b,则 Y :

1

|k|

p

X

(

y−b

k

)(直接运用定理即可)

【总结】

34

13 随机变量函数的分布

1. 只要 y = f(x) 在 p

X

(x) 中 x 起作用的区间内单调,就可用定理法

2. pY (y) 中 y 的范围由

(

y = f(x)

p

X

(x)中 x 起作用段

共同决定

给出如下证明,证明过程不难:

证明. 不妨设 y = g(x) 严格单调增加,则它的反函数 x = h(y) 存在,且也严格单调增加。因为

Y = g(X) 在区间

α = g(−∞), β = g(+∞)

之间取值

所以当 y ≤ α 时, F

Y

(y) = P (Y ≤ y) = 0

当 y ≥ β 时,F

Y

(y) = P (Y ≤ y) = 1

当 α < y < β 时,F

Y

(y) = P (Y ≤ y) = P (g(X) ≤ y) = P (X ≤ h(y)) =

R

h(y)

−∞

p

X

(x)dx

于是,Y 的概率密度函数为

p

Y

(y) =

(

p

X

[h(y)]h

′

(y) a < y < b

0 else

g(x) 严格单调减函数的情形可以类似证明。但要注意的是,此时 h

′

(y) < 0,因此需要加上绝对

值符号,这时 (α = g(∞), β = g(−∞))。

沿用上述例题来说明上述定理的应用。

【例题】设 X ∼ exp(1),求 Y = X

2

的概率密度。

解:X ∼ p

X

(x) =

e

−x

x > 0

0 else

当 x > 0 时,函数 y = x

2

单调递增,由定理

p

Y

(y) =

p

X

(h(y)) |h

′

(y)| α < y < β

0 else

=

(

e

−

√

y

2

√

y

y > 0

0 else

利用定理13.1,可以证明以下定理。

定理 13.2. 正态变量的线性不变性

随机变量 X ∼ N(µ, σ

2

),则当 a ̸= 0 时,有 Y = aX + b ∼ N (aµ + b, a

2

σ

2

)。

定理 13.3. 对数正态分布

随机变量 X N (µ, σ

2

),则 Y = e

x

的概率密度函数为

P

Y

(y) =

(

1

√

2πyσ

exp{−

(lny−µ)

2

2σ

2

} , y > 0

0 , y ≤ 0

且 Y 称服从对数正态分布,记为 Y ∼ LN

µ, σ

2

,其中 µ 称为对数均值,σ

2

称为对数

方差。

对数正态分布是偏态分布,也是一个常用分布。例如:绝缘体材料的寿命、设备故障的维修时间、

家中仅有两个小孩的年龄差从夫对数正态分布。

定理 13.4

随机变量 X ∼ Ga(α, λ),则当 k > 0 时,有 Y = kX ∼ Ga(α, λ/k)。

35

14 分布的其它特征数

定理 13.5

随机变量 X 的分布函数 F

X

(x) 是严格单调的连续函数,其反函数 F

−1

X

(x) 存在,则 Y =

F

X

(X) 服从 [0, 1] 上的均匀分布。

证明. 求 Y 的分布函数就是求 F

X

(X) 的分布函数。因为 F

X

(X) 仅在 [0, 1] 上面取值,所以

当 y < 0 时

F

Y

(y) = P (Y ≤ y) = P (F

X

(X) ≤ y) = 0

当 0 ≤ y ≤ 1 时

F

Y

(y) = P (Y ≤ y) = P (F

X

(X) ≤ y) = P (X ≤ F

−1

X

(y)) = F

X

(F

−1

X

(y)) = y

当 1 < y 时,F

Y

(y) = 1

Note: 该定理表明均匀分布在连续分布类中占有特殊地位,因为任意一个连续随机变量

都可以通过其分布函数与均匀分布发生关系。

利用该推论,可以通过生成均匀分布随机数的方法生成一些其他分布的随机数。

14 分布的其它特征数

14.1 k 阶矩

定义14.1 k 阶矩:对于正整数 k 与随机变量 X,如果以下数学期望都存在,则有:

原点矩 (Raw moment):µ

k

= E(X

k

)

中心矩 (Central moment):v

k

= E

(X −EX)

k

标准矩 (Standardized moment):ˆµ

k

=

µ

k

[V ar(X)]

k/2

对以上整数 k 的情形,统称为 k 阶矩 (k-th moment)。

定理 14.1

高阶矩存在,则低阶矩必定存在。

证明. 通过定义的方法证明:

k 阶矩 E|X|

k

就是积分

R

|X|

k

dP ,当 k + 1 阶矩存在时,k 阶矩这个积分可以分为 |X| > 1 和

|X| ≤ 1 两部分分别积分然后加起来,前一部分积分 ≤ |X|

(

k+1) 的积分,因为 |X|

k

<= |X|

(

k+1)

(当 |X| > 1 时),后一部分积分 ≤ 1,所以加起来仍然是有限的。也就是 |X|

k−1

≤ |X|

k

+ 1

因此 k + 1 阶矩有限意味着 k 阶矩有限。

Note: 在概率论中,矩的本质是期望,期望存在要求级数绝对收敛,而 |X|

k−1

≤ |X|

k

+ 1

即意味着,若高阶矩存在,那么高阶级数一定绝对收敛,低阶级数小于高阶级数,则低阶

级数也收敛。

36

14 分布的其它特征数

14.1.1 中心矩与原点矩的关系

中心矩与原点矩的关系:

v

k

= E(X − µ

1

)

k

=

k

X

i=0

k

i

µ

i

(−µ

1

)

k−i

因此有:

v

1

= 0

v

2

= µ

2

− µ

2

1

v

3

= µ

3

− 3µ

2

µ

1

+ 2µ

3

1

14.2 变异系数(离散系数)

变异系数也称为离散系数 (coecient of variation),它是一组数据的标准差与其相应的平均数之

比。

若随机变量 X 的二阶矩存在,则 X 的变异系数为:

C

v

(X) =

p

V ar(X)

E(X)

=

σ(X)

E(X)

方差和标准差反映了数据离散程度,用方差或标准差去比较两个随机变量的离散程度的时候,会

有两个问题:

1. 方差或标准差数值的大小受原变量值自身水平高低的影响,也就是与变量的平均数大小有

关,变量值绝对水平高的,离散程度的测度值自然也就大,绝对水平低的离散程度的测度

值自然也就小

2. 方差或标准差与原变量值的计量单位相同,采用不同计量单位计量的变量值,其离散程度

的测度值也就不同。

因此,对于平均水平不同或计量单位不同的不同组别的变量值,是不能用标准差直接比较其离散

程度的。为消除变量值水平高低和计量单位不同对离散程度测度值的影响,需要引进变异系数。

显然变异系数是一个无量纲的量,因为标准差与期望的量纲是一致的,两者的量纲相抵消。

14.3 分位数

设 X F (x),密度函数为 p(x),对任意 p ∈ (0, 1),称满足下述条件的 x

p

为此分布的分位数,又

称为下侧 p 分位数。

F (x

p

) =

Z

x

p

−∞

p(x)dx = p

同理,我们称满足下述条件的 x

′

p

为此分布的上侧分位数。

1 − F (x

′

p

) =

Z

−∞

x

′

p

p(x)dx = p

下侧分位与上侧分位数可以相互转换

x

′

p

= x

1−p

x

p

= x

′

1−p

37

15 参考文献

14.4 中位数

X F (x),p = 0.5 时的 p 分位数 x

0.5

是 F (x) 的中位数。

F (x

0.5

) =

Z

x

0.5

−∞

p(x)dx = 0.5

14.5 偏度

偏度是随机变量 X 的三阶标准矩,用于描述分布偏离对称性。如果随机变量 X 的前三阶矩存

在,则比值:

β

s

=

v

3

v

3

2

2

=

E(X − EX)

3

[V ar(X)]

3/2

= E

"

X −EX

SD(X)

3

#

称为 X 的偏度系数,简称偏度 (Skewness)。偏度值大于 0 时称为正偏或右偏 (right-skewed),

小于零时称为负偏或左偏 (left-skewed)。

14.6 峰度

峰度是随机变量 X 的四阶标准矩,用于描述分布尖峭程度与(或)尾部粗细。如果随机变量 X

的前四阶矩存在,则:

β

k

=

v

4

v

2

2

− 3 =

E(X − EX)

4

[V ar(X)]

2

称为 X 的峰度系数,简称峰度 (Kurtosis),有时也记作 Kurt[X]。峰度值大于 0 表示分布比

标准正态分布更尖峭、尾部更粗;小于 0 表示比标准正态分布更平坦、尾部更细。

15 参考文献

[1] 茆诗松,程依明,濮晓龙. 概率论与数理统计教程(第二版). 高等教育出版社. 2010

[2] 陈希孺. 概率论与数理统计. 中国科学技术大学出版社.2009

[3] 贾俊平,何晓群,金勇进. 统计学(第六版). 中国人民大学出版社. 2014

38

第三部分

概率论进阶

39

16 随机变量序列的四种收敛

16 随机变量序列的四种收敛

定义16.1 弱收敛 (convergence in distribution):设置随机变量 X, X

1

, X

2

, ··· 的分布函数分

别为 F (x), F

1

(x), F

2

(x), ···。若对 F (x) 的任一连续点 x,都有

lim

n→∞

F

n

(x) = F (x)

则称 {F

n

(x)} 弱收敛于 F (x),记作 F

n

(x)

W

→ F (x)。也称 {X

n

} 按分布收敛于 X,记作 X

n

d

→ X。

Note: 也就是说,当 n 很大的时候,X

n

的累积函数和 X 的累积函数(的取值)无限接

近。直观上而言,依分布收敛只在乎随机变量的分布,而不在乎他们之间的相互关系。

举一个例子:倘若已知 X

n

d

→ X,假设 Y = −X。对于任意一个发生的事件,Y 与 X 的取值正好

反号。但这并不影响 X 与 Y 有相同的累积分布函数,即 F

X

(z) = F

Y

(z)。如此一来,X

n

d

→ Y 。

更一般的情况而言,只要 X 与 Y 有相同的累计函数,即 same distributed,即使 P (X = Y ) < 1,

也有 X

n

d

→ Y 。因为依分布收敛仅仅在乎分布,而不在乎相互之间的关系。

定义16.2 依概率收敛 (convergence in probability):设 {X

n

} 为一随机变量序列,X 为一随

机变量,如果对任意 ∀ε > 0 有

lim

n→∞

P (|X

n

− X| ≥ ε) → 0

则称 {X

n

} 依概率收敛于 X,记作 X

n

P

→ X。

Note: 也就是说,当 n 很大的时候,对任意发生的事件,X

n

的值和 X 的值不相等的概

率趋向 0,但 |X

n

−X| 依然有概率取比较大的值。直观上而言,依概率收敛在乎的是随机

变量的值。

这样说来,前面依分布收敛的例子如果套在概率收敛上就会出现问题。如果 X

n

d

→ Y ,但对于任

何一个与 X 分布一样的 Y ,P (X = Y ) < 1 不一定成立,因为 X 与 Y 只是分布相同,而值不

同。但反而言之,如果 X

n

P

→ X,即它们的值都差不多了,那么它们的分布一定也差不多,即

X

n

d

→ X。因此,依概率收敛比依分布收敛要强,即 X

n

P

→ X ⇒ X

n

d

→ X。

但在某种情况下,取值就可以确定分布。即 X 取某个常数的情况下(退化分布)。此时 X 的取

值和 X 的分布唯一确定。即此时会有依分布收敛和依概率收敛等价,即 X

n

P

→ X ⇔ X

n

d

→ X。

定义16.3 几乎必然收敛 (convergence almost surely):随机变量序列 {X

n

} 几乎必然收敛收

敛于随机变量 X,即 X

n

as

→ X,当且仅当

P ( lim

n→∞

|X

n

–X| < ε) = 1

其中 ε 为任意正实数。

Note: 依概率收敛、几乎必然收敛的区别

依概率收敛要求随着 n 的增大 X

n

与 X 不相等的概率越来越小,即 X

n

出现其他值的概

率越来越小,极限为 0。

而几乎必然收敛则是要求,存在 N,当 n > N 时,X

n

= X 必须成立。

即依概率收敛限制尾部概率收敛至 0,而几乎必然收敛限制尾部概率等于 0。

定义16.4 Lp 收敛 (convergence in Lp):随机变量序列 {X

n

} 依 Lp 收敛于随机变量 X,即

X

n

L

p

→ X,当且仅当

41

17 大数定律

E(X

n

− X)

p

→ 0 , n → ∞ p ≥ 1

当 p = 2 时称为均方收敛。

直观上而言,均方收敛在乎的也是随机变量的值,但要求比依概率收敛更严格,因为根据切比雪

夫不等式,概率测度被均方限制。由切比雪夫不等式:

P (|X − µ| ≥ ε) ≤

E(X − µ)

2

ε

2

因此,X

n

L

2

→ X ⇒ X

n

P

→ X。

总结

1. 几乎处处收敛和 Lp 收敛最强,依概率收敛其次,依分布收敛最弱。

2. 几乎处处收敛和 Lp 收敛并无推导关系。

3. 在收敛到常数时,依概率收敛和依分布收敛等价。

4. 比几乎处处收敛更强的是数学分析中的完全收敛。

17 大数定律

17.1 伯努利大数定律

伯努利大数定律是研究这种极限定理的第一个定律,也是一个从理论上证明随机现象的频率具

有稳定性的定律。

定理 17.1. 伯努利大数定律

设 µ

n

是 n 重伯努利试验中事件 A 出现的次数,而 p 是事件 A 在每次试验中出现的概

率,则对任意 ε > 0,都有

lim P

n→∞

{|

µ

n

n

− p| < ε} = 1

定理的含义:µ

n

是 n 重伯努利试验中 A 出现的次数,则

µ

n

n

便是这 n 次试验中 A 出现的频率,

上式表明,当次数 n 很大时,事件 A 出现的频率与事件 A 出现的概率 p 的偏差超过任意正数

的可能性很小,或者基本上说,是不可能的。

证明.

E(

µ

n

n

) = E(

1

n

n

X

i=1

X

i

) =

1

n

n

X

i=1

E(X

i

) = p

D

(

µ

n

n

) =

D

(

1

n

n

X

i=1

X

i

) =

1

n

2

n

X

i=1

D

(

X

i

) =

pq

n

由切贝雪夫不等式有:P {|

µ

n

n

− p| ≥ ε} ≤

D(

µ

n

n

)

ε

2

=

pq

nε

2

当 n → ∞,

pq

nε

2

→ 0,因此 lim P {|

µ

n

n

− p| ≥ ε} = 0,亦即 lim

n→∞

P {|

µ

n

n

− p| < ε} = 1。

伯努利大数定律证明了在大量重复的伯努利试验中,随机事件的频率在它的概率的附近摆动,若

事件的概率很小,则事件的频率也很小,或者说事件很少发生。

伯努利大数定律还提供了通过试验来确定事件概率的方法。既然频率

µ

n

n

与概率

p

有较大偏差

的可能性很小,那么就可以通过做试验确定某事件发生的频率并把它作为相应概率的估计。这

是参数估计的内容,参数估计是数理统计中主要的研究课题之一。参数估计的一个重要理论基

础就是大数定律。

42

17 大数定律

17.2 大数定律一般形式

在伯努利大数定律的形式下,可推广出大数定律的一般形式。在伯努利大数定律中:

µ

n

n

=

1

n

n

P

i=1

X

i

,

p = E(

1

n

n

P

i=1

X

i

) =

1

n

E(

n

P

i=1

X

i

),因此有:

定理 17.2. 大数定律一般形式

设有一随机变量序列 {X

n

},假如它具有形如下式的性质,则称该随机变量序列 {X

n

} 服

从大数定律:∀ε > 0

lim

n→+∞

P {

1

n

n

X

i=1

X

i

−

1

n

n

X

i=1

E(X

i

)

< ε} = 1

Note: 也就是

lim

n→+∞

P {

¯

X − µ

< ε} = 1

大数定律的本质就是样本均值依概率收敛于期望。

独立同分布随机变量序列 {X

n

} 服从大数定律是依概率收敛的特殊情况。构造另外一个随

机序列 {Y

n

},其中,Y =

1

n

n

P

i=1

E(X

i

) = µ,则 {X

n

} 服从大数定律等价于 Y

n

P

→µ。依概

率收敛是把原收敛于一个常数 µ 推广到收敛于一个随机变量场合。

大数定理有两种用法:

1. 当样本足够多的时候,样本均值和分布均值足够接近的概率非常大

2. 当样本足够多的时候,可以用样本均值来近似分布均值。

问题来了,随机变量序列 {X

n

} 在什么条件下满足定理 17.2呢?以下的大数定律的差别就是在

条件上。

17.3 切比雪夫大数定律

定理 17.3. 切比雪夫大数定律

设 {X

n

} 为一列两两不相关的随机变量序列,若每个 X

i

的方差存在,且有共同的上界,

即 V ar(X

i

) ≤ c, i = 1, 2, ···,则 {X

n

} 服从大数定律。

43

17 大数定律

17.4 马尔可夫大数定律

马尔可夫条件:

1

n

2

V ar(

n

X

i=1

X

i

) → 0

定理 17.4. 马尔可夫大数定律

对随机变量序列 {X

n

},若马尔可夫条件成立,则 {X

n

} 服从大数定律。

该定理的条件中没有任何同分布、独立性、不相关的假定。

17.5 辛钦大数定律

定理 17.5. 辛钦大数定律

设 {X

n

} 为一独立同分布的随机变量序列,若 X

i

的数学期望存在,则 {X

n

} 服从大数定

律。

注意:该定理提供了求随机变量数学期望 E(X) 的近似值方法。

17.6 总结

定律 分布情况 期望 方差 结论

辛钦大数定律 独立同分布 存在 — 估算期望

马尔可夫大数定律 — — 马尔可夫条件 估算期望

切比雪夫大数定律 两两不相关 — 存在,上界相同 估算期望

伯努利大数定律 二点分布 相同 相同 频率 = 概率

马尔可夫大数定律、切比雪夫大数定律虽然没有写明要求随机变量的期望存在,但是要求方差存

在。而方差存在,则期望必定存在。